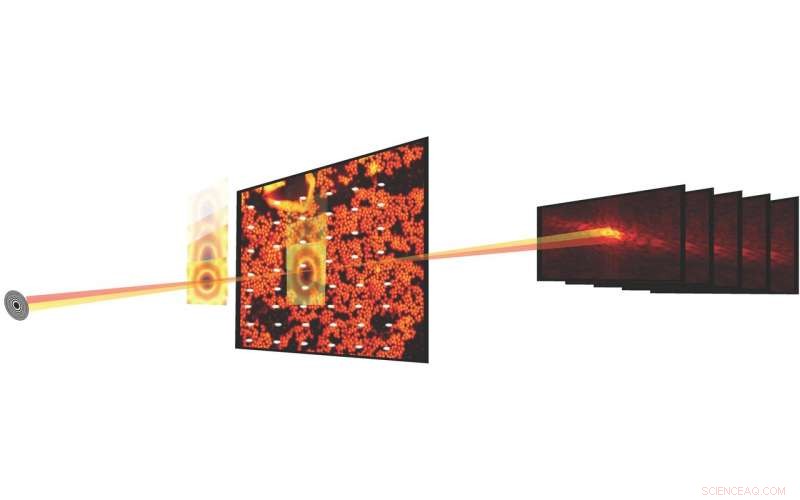

Dans les expériences scientifiques, L'imagerie ptychographique combine la microscopie à balayage avec des mesures de diffraction pour caractériser la structure et les propriétés de la matière et des matériaux. Les progrès des détecteurs et des microscopes à rayons X sur les sources lumineuses ont permis de mesurer désormais un ensemble de données ptychographiques en quelques secondes. Crédit :Stefano Marchesini, Laboratoire de Berkeley

Ce qui a commencé il y a près d'une décennie comme une proposition de recherche et développement dirigés par le laboratoire de Berkeley Lab (LDRD) est maintenant une réalité, et cela change déjà la façon dont les scientifiques mènent des expériences à la source lumineuse avancée (ALS) - et, finalement, d'autres sources lumineuses dans le complexe du ministère de l'Énergie (DOE), en permettant la diffusion en temps réel de données d'images ptychographiques dans un environnement de production.

Dans les expériences scientifiques, L'imagerie ptychographique combine la microscopie à balayage avec des mesures de diffraction pour caractériser la structure et les propriétés de la matière et des matériaux. Bien que la méthode existe depuis une cinquantaine d'années, une large utilisation a été entravée par le fait que le processus expérimental était lent et que le traitement informatique des données pour produire une image reconstruite était coûteux. Mais ces dernières années, les progrès des détecteurs et des microscopes à rayons X à des sources lumineuses telles que l'ALS ont permis de mesurer un ensemble de données ptychographiques en quelques secondes.

Reconstituer des jeux de données ptychographiques, cependant, n'est pas une mince affaire; le processus consiste à résoudre un problème difficile de récupération de phase, l'étalonnage des éléments optiques et le traitement des valeurs aberrantes expérimentales et du « bruit ». Entrez SHARP (ptychographie adaptative en temps réel hétérogène évolutive), un cadre algorithmique et un logiciel informatique qui permet la reconstruction de millions de phases de données d'images ptychographiques par seconde. Développé au Berkeley Lab dans le cadre d'une collaboration internationale et déployé en 2016, SHARP a eu un impact démontrable sur la productivité des scientifiques travaillant à l'ALS et à d'autres sources lumineuses du complexe du ministère de l'Énergie.

Désormais une collaboration intergouvernementale financée par des scientifiques du Centre de mathématiques avancées pour les applications de recherche énergétique (CAMERA) de Berkeley Lab, financé par le DOE, l'ALS et le STROBE, le Centre scientifique et technologique de la National Science Foundation, a produit une autre avancée unique en son genre pour l'imagerie ptychographique :un pipeline logiciel/algorithmique qui permet la diffusion en temps réel de données d'images ptychographiques lors d'une expérience de ligne de lumière, fournir un débit, compression et résolution ainsi qu'un retour rapide à l'utilisateur pendant que l'expérience est toujours en cours.

Intégré, Modulaire, Évolutif

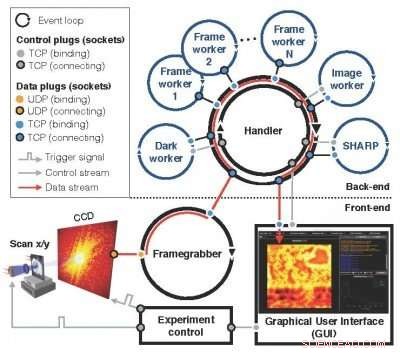

Successeur du concept Nanosurveyor introduit pour la première fois dans une proposition LDRD de 2010, le modulaire, le système évolutif Nanosurveyor II, désormais opérationnel à l'ALS, utilise une infrastructure recto-verso qui intègre l'acquisition de données d'images ptychographiques, prétraitement, processus de transmission et de visualisation. Le composant frontal de la ligne de lumière comprend le détecteur, Frame grabber, un préprocesseur évolutif et une interface utilisateur graphique (GUI), tandis que le composant back-end du cluster de calcul contient SHARP pour la reconstruction d'images haute résolution combiné à des canaux de communication pour le flux de données, instructions et synchronisation. En opération, une fois qu'un nouveau scan a été déclenché par le contrôle d'expérimentation, le frame-grabber reçoit en continu des paquets de données brutes de la caméra, les assemble sur un cadre et, en parallèle, prétraite un ensemble de trames brutes en un bloc propre et réduit pour le back-end de calcul. Les blocs entrants sont répartis entre les travailleurs SHARP dans le back-end de calcul, et les données réduites sont renvoyées au front-end et visualisées dans une interface graphique. Le nouveau système logiciel de streaming est en cours de déploiement à l'ALS pour une utilisation active dans les expériences sur les lignes de lumière, comme la plate-forme de microscopie à rayons X COSMIC récemment mise en ligne.

"Ce que nous avons réussi à faire, c'est rendre les calculs et les flux de données très complexes aussi transparents que possible, " a déclaré David Shapiro, un scientifique du groupe des systèmes expérimentaux de l'ALS qui a contribué à faciliter la mise en œuvre et les tests du nouveau système. "Une fois le logiciel lancé, les opérateurs de microscope n'ont aucune idée qu'ils génèrent des gigaoctets de données et qu'elles passent par ce pipeline puis leur reviennent."

Les utilisateurs de l'ALS peuvent généralement utiliser les lignes de lumière pendant environ deux jours, au cours de laquelle ils peuvent étudier une dizaine d'échantillons, a noté Shapiro. Cela signifie qu'ils n'ont que quelques heures par échantillon, et ils doivent prendre un certain nombre de décisions concernant les données dans ces heures. La capacité de streaming en temps réel pytchographique leur donne un retour en temps réel et les aide à prendre des décisions plus précises.

Le modulaire, le système évolutif Nanosurveyor II, désormais opérationnel à l'ALS, utilise une infrastructure recto-verso qui intègre l'acquisition de données d'images ptychographiques, prétraitement, processus de transmission et de visualisation. Crédit :Lawrence Berkeley National Laboratory

"Le fait que SHARP puisse désormais prendre des données en temps réel et les traiter immédiatement, même si l'expérience n'est pas terminée, le rend performant et opérationnel pour la science dans un environnement de production, " a déclaré Stefano Marchesini, un scientifique de CAMERA et le PI sur la proposition originale du LDRD.

Environnement prêt pour la production

L'intégration de tous les composants a été l'un des plus grands défis de la mise en œuvre de Nanosurveyor II, tout comme la préparation pour fonctionner dans un environnement prêt pour la production par rapport à un banc d'essai, selon Hari Krishnan, un ingénieur en systèmes informatiques chez CAMERA qui était responsable du développement du moteur de communication du pipeline. Il a fallu plusieurs années d'efforts pour concrétiser les capacités de traitement des données en temps réel, avec des contributions de mathématiciens, informaticiens, ingénieurs logiciels, physiciens et scientifiques des lignes de lumière. En plus de Marchesini et Krishnan, Les scientifiques de CAMERA Pablo Enfedaque et Huibin Chang ont participé au développement de l'interface SHARP et du moteur de communication. En outre, Filipe Maia et Benedict Daurer de l'Université d'Uppsala, qui a une collaboration avec CAMERA, joué un rôle essentiel dans le développement du logiciel de streaming. Pendant ce temps, le physicien Bjoern Enders du département de physique de Berkeley et STROBE s'est concentré sur le détecteur et le préprocesseur, et Berkeley Ph.D. Ph.D. l'étudiante Kasra Nowrouzi a participé à la mise en œuvre du pipeline.

"Il était important de séparer les responsabilités et les tâches du système, puis de trouver une interface commune pour communiquer, " Enders a déclaré à propos de l'effort d'équipe. "Cela a remis une partie de la responsabilité dans la ligne de lumière. Nous avons tous travaillé ensemble pour séparer proprement l'algorithme de streaming de la partie de prétraitement afin que nous puissions nous assurer que la ligne de lumière fonctionne réellement. »

Regarder vers l'avant, L'évolutivité de Nanosurveyor II sera cruciale à mesure que la prochaine génération de sources lumineuses et de détecteurs sera mise en ligne. Les débits de données du pipeline reflètent ceux du détecteur ; le détecteur actuel fonctionne à une vitesse pouvant atteindre 400 mégaoctets par seconde et peut générer quelques téraoctets de données par jour. Les détecteurs de nouvelle génération produiront des données 100 à 1, 000 fois plus rapide.

« La solution de streaming fonctionne aussi vite que l'acquisition de données à ce stade, " A déclaré Enfedaque. "Vous pouvez reconstruire l'image ptychographique à la vitesse à laquelle les données sont capturées et pré-traitées."

En outre, l'équipe cherche à améliorer les capacités du pipeline en incorporant des algorithmes d'apprentissage automatique qui peuvent automatiser davantage le processus d'analyse des données.

"L'objectif est de le rendre transparent, " a déclaré Krishnan. " En ce moment, ce que les utilisateurs regardent est une image grossière pour prendre des décisions rapides et une image plus fine pour prendre des décisions plus complexes. Finalement, nous voulons nous éloigner complètement des images et des données brutes et nous retrouver dans ce domaine où toutes les décisions et tous les points ne sont qu'une seule image reconstruite. Toutes ces autres choses intermédiaires disparaissent."

"La capacité de flux de données apporte l'analyse à l'échelle de temps de la prise de décision humaine pour les opérateurs, mais il facilite aussi l'avenir, qui seraient des machines prenant des décisions et guidant les mesures, " ajouta Shapiro.