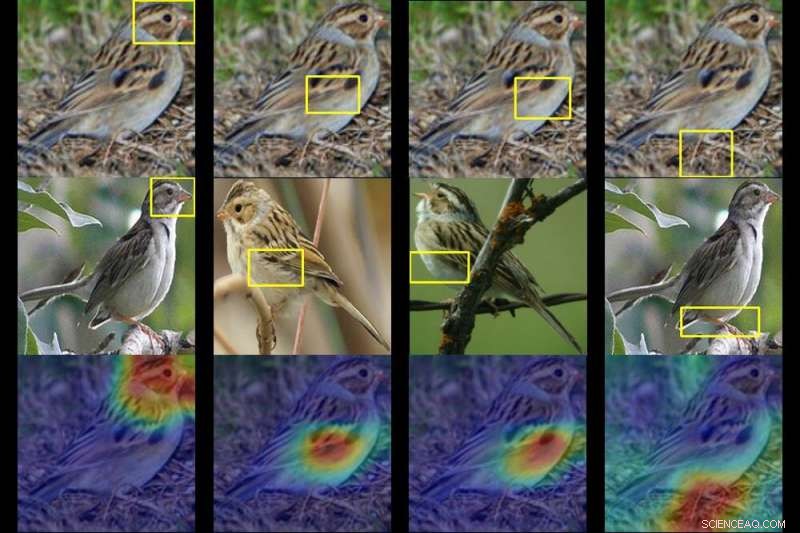

Une équipe de Duke a formé un ordinateur pour identifier jusqu'à 200 espèces d'oiseaux à partir d'une simple photo. Étant donné une photo d'un oiseau mystérieux (en haut), l'IA crache des cartes thermiques montrant quelles parties de l'image sont les plus similaires aux caractéristiques typiques des espèces qu'elle a vues auparavant. Crédit :Université Duke

Cela peut prendre des années d'expérience en observation des oiseaux pour distinguer une espèce d'une autre. Mais en utilisant une technique d'intelligence artificielle appelée apprentissage profond, Des chercheurs de l'université Duke ont entraîné un ordinateur à identifier jusqu'à 200 espèces d'oiseaux à partir d'une simple photo.

La vraie nouveauté, cependant, est-ce que l'A.I. outil montre aussi sa pensée, d'une manière que même quelqu'un qui ne connaît pas un pingouin d'un macareux peut comprendre.

L'équipe a entraîné son réseau de neurones profonds - des algorithmes basés sur le fonctionnement du cerveau - en le nourrissant 11, 788 photos de 200 espèces d'oiseaux à découvrir, allant des canards nageurs aux colibris en vol stationnaire.

Les chercheurs n'ont jamais dit au réseau "c'est un bec" ou "ce sont des plumes d'ailes". Étant donné une photo d'un oiseau mystérieux, le réseau est capable de repérer des modèles importants dans l'image et de tenter une supposition en comparant ces modèles aux traits d'espèces typiques qu'il a déjà vus.

En cours de route, il crache une série de cartes thermiques qui disent essentiellement :"Ce n'est pas n'importe quelle paruline. C'est une paruline à capuchon, et voici les traits, comme sa tête masquée et son ventre jaune, qui le trahissent."

Docteur en informatique Duke l'étudiant Chaofan Chen et le premier cycle Oscar Li ont dirigé la recherche, ainsi que d'autres membres de l'équipe du laboratoire d'analyse de prédiction dirigé par le professeur Duke Cynthia Rudin.

Ils ont découvert que leur réseau neuronal est capable d'identifier la bonne espèce jusqu'à 84 % du temps, à égalité avec certains de ses homologues les plus performants, qui ne révèlent pas comment ils sont capables de le dire, dire, un moineau de l'autre.

Rudin dit que leur projet ne se limite pas à nommer des oiseaux. Il s'agit de visualiser ce que les réseaux de neurones profonds voient réellement lorsqu'ils regardent une image.

Une technologie similaire est utilisée pour taguer les personnes sur les sites de réseaux sociaux, repérer les criminels présumés dans les caméras de surveillance, et entraînez les voitures autonomes à détecter des éléments tels que les feux de circulation et les piétons.

Le problème, Rudin dit, est que la plupart des approches d'apprentissage en profondeur de la vision par ordinateur sont notoirement opaques. Contrairement aux logiciels traditionnels, le logiciel d'apprentissage en profondeur apprend à partir des données sans être explicitement programmé. Par conséquent, La manière exacte dont ces algorithmes « pensent » lorsqu'ils classent une image n'est pas toujours claire.

Rudin et ses collègues essaient de montrer que l'A.I. ne doit pas être de cette façon. Elle et son laboratoire conçoivent des modèles d'apprentissage en profondeur qui expliquent le raisonnement derrière leurs prédictions, en précisant exactement pourquoi et comment ils ont trouvé leurs réponses. Lorsqu'un tel modèle fait une erreur, sa transparence intégrée permet de voir pourquoi.

Pour leur prochain projet, Rudin et son équipe utilisent leur algorithme pour classer les zones suspectes dans les images médicales comme les mammographies. Si ça marche, leur système n'aidera pas seulement les médecins à détecter les grumeaux, calcifications et autres symptômes qui pourraient être des signes de cancer du sein. Il montrera également sur quelles parties de la mammographie il se dirige, révélant quelles caractéristiques spécifiques ressemblent le plus aux lésions cancéreuses qu'il a déjà vues chez d'autres patients.

De cette façon, Rudin dit, leur réseau est conçu pour imiter la façon dont les médecins posent un diagnostic. "C'est un raisonnement basé sur des cas, " a déclaré Rudin. "Nous espérons pouvoir mieux expliquer aux médecins ou aux patients pourquoi leur image a été classée par le réseau comme maligne ou bénigne."

L'équipe présente un article sur ses conclusions à la trente-troisième conférence sur les systèmes de traitement de l'information neuronale (NeurIPS 2019) à Vancouver le 12 décembre.