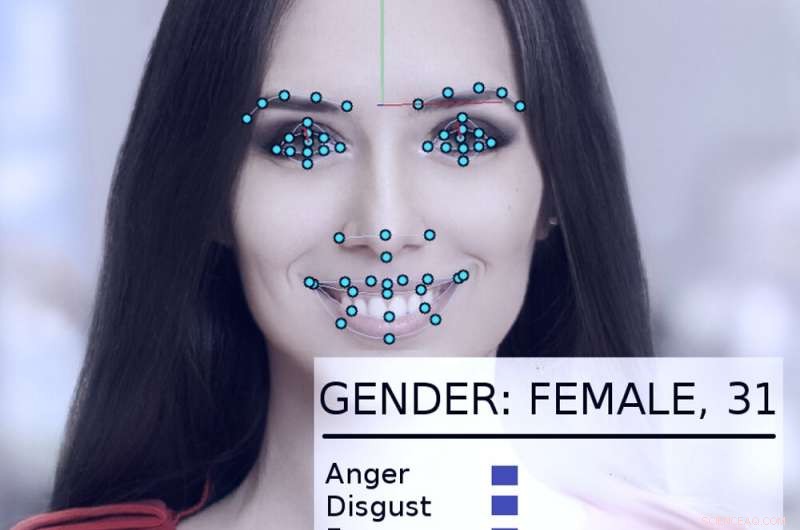

Un système de suivi et d'analyse du visage examine le visage d'une femme. Crédit :Abyssus/Wikimedia Commons, CC BY-SA

Les systèmes d'intelligence artificielle peuvent - s'ils sont correctement utilisés - aider à rendre le gouvernement plus efficace et réactif, améliorer la vie des citoyens. Mal utilisé, cependant, les visions dystopiques du "1984" de George Orwell deviennent plus réalistes.

Seuls et poussés par un nouveau décret présidentiel, gouvernements à travers les États-Unis, y compris les agences étatiques et fédérales, explorent des moyens d'utiliser les technologies de l'IA.

En tant que chercheur en IA depuis plus de 40 ans, qui a été consultant ou participant à de nombreux projets gouvernementaux, Je crois qu'il vaut la peine de noter que parfois ils l'ont bien fait – et d'autres fois moins bien. Les dommages et les avantages potentiels sont importants.

Un succès précoce

En 2015, le département américain de la Sécurité intérieure a développé un système d'IA appelé "Emma, " un chatbot capable de répondre aux questions qui lui sont posées en anglais régulier, sans avoir besoin de savoir ce que "son" site Web d'introduction appelle "le discours du gouvernement" - tous les termes et acronymes officiels utilisés dans les documents de l'agence.

Fin 2016, Le DHS a rapporté qu'Emma aidait déjà à répondre à près d'un demi-million de questions par mois, permettant au DHS de traiter beaucoup plus de demandes qu'auparavant, et laisser les employés humains passer plus de temps à aider les gens avec des requêtes plus complexes qui dépassent les capacités d'Emma. Ce type d'intelligence artificielle automatisant la conversation est maintenant utilisé par d'autres agences gouvernementales, dans les villes et les pays du monde.

L'eau de silex

Un exemple plus compliqué de la façon dont les gouvernements pourraient appliquer judicieusement l'IA peut être vu dans Flint, Michigan. Alors que les gouvernements locaux et étatiques luttaient pour lutter contre la contamination par le plomb de l'eau potable de la ville, il est devenu évident qu'ils auraient besoin de remplacer les conduites d'eau en plomb restantes de la ville. Cependant, les registres de la ville étaient incomplets, et il allait être extrêmement coûteux de déterrer tous les tuyaux de la ville pour voir s'ils étaient en plomb ou en cuivre.

Au lieu, informaticiens et fonctionnaires ont collaboré pour analyser un large éventail de données sur chacun des 55, 000 propriétés dans la ville, y compris l'âge de la maison, pour calculer la probabilité qu'il soit desservi par des tuyaux en plomb. Avant l'utilisation du système, 80% des canalisations déterrées devaient être remplacées, ce qui signifiait 20% du temps, de l'argent et des efforts étaient gaspillés pour des tuyaux qui n'avaient pas besoin d'être remplacés.

Le système d'IA a aidé les ingénieurs à se concentrer sur les propriétés à haut risque, l'identification d'un ensemble de propriétés les plus susceptibles d'avoir besoin de remplacements de canalisations. Lorsque les inspecteurs de la ville se sont rendus pour vérifier la situation, l'algorithme avait raison 70% du temps. Cela promettait d'économiser d'énormes sommes d'argent et d'accélérer le processus de remplacement des tuyaux.

Cependant, la politique locale s'en est mêlée. De nombreux membres du public ne comprenaient pas pourquoi le système identifiait les maisons qu'il faisait, et s'y oppose, disant que la méthode de l'IA ignorait injustement leurs maisons. Après que les autorités municipales ont cessé d'utiliser l'algorithme, seulement 15 % des tuyaux déterrés étaient en plomb. Cela a rendu le projet de remplacement plus lent et plus coûteux.

Exemples pénibles

Le problème à Flint était que les gens ne comprenaient pas que la technologie de l'IA était bien utilisée, et que les gens vérifiaient ses conclusions avec des inspections indépendantes. En partie, c'était parce qu'ils ne faisaient pas confiance à l'IA - et dans certains cas, il y a une bonne raison à cela.

En 2017, Je faisais partie d'un groupe de plus de quatre douzaines de chercheurs en IA qui ont envoyé une lettre au secrétaire par intérim du département américain de la Sécurité intérieure. Nous avons exprimé des inquiétudes au sujet d'une proposition visant à utiliser des systèmes automatisés pour déterminer si une personne demandant l'asile aux États-Unis deviendrait un « membre contribuant positivement à la société » ou était plus susceptible de constituer une menace terroriste.

"Tout simplement, " notre lettre disait, "aucune méthode de calcul ne peut fournir des évaluations fiables ou objectives des traits que [DHS] cherche à mesurer." Nous avons expliqué que l'apprentissage automatique est susceptible d'un problème appelé "data skew, " dans laquelle la capacité du système à prédire une caractéristique dépend en partie de la fréquence de cette caractéristique dans les données utilisées pour entraîner le système.

Donc dans une base de données de 300 millions d'Américains, si une personne sur 100 l'est, dire, d'origine indienne, le système sera assez précis pour les identifier. Mais si l'on considère une caractéristique partagée par seulement un Américain sur un million, il n'y a vraiment pas assez de données pour que l'algorithme fasse une bonne analyse.

Comme l'expliquait la lettre, "à l'échelle de la population américaine et des taux d'immigration, les actes criminels sont relativement rares, et les actes terroristes sont extrêmement rares. » L'analyse algorithmique est extrêmement peu susceptible d'identifier des terroristes potentiels. Heureusement, nos arguments se sont avérés convaincants. En mai 2018, Le DHS a annoncé qu'il n'utiliserait pas d'algorithme d'apprentissage automatique de cette manière.

D'autres efforts inquiétants

D'autres utilisations gouvernementales de l'IA sont remises en question, aussi – comme les tentatives de « police prédictive, " fixer des montants de caution et des peines pénales et embaucher des fonctionnaires. Tous ces éléments se sont révélés sensibles à des problèmes techniques et à des limitations de données qui peuvent biaiser leurs décisions en fonction de la race, genre ou origine culturelle.

D'autres technologies d'IA telles que la reconnaissance faciale, la surveillance automatisée et la collecte massive de données soulèvent de réelles inquiétudes en matière de sécurité, intimité, l'équité et l'exactitude dans une société démocratique.

Comme le montre le décret de Trump, il y a un intérêt important à exploiter l'IA pour son plein potentiel positif. Mais les dangers importants d'abus, les abus et les préjugés – qu'ils soient intentionnels ou non – ont le potentiel d'aller à l'encontre des principes mêmes sur lesquels les démocraties internationales ont été construites.

À mesure que l'utilisation des technologies d'IA se développe, qu'ils soient à l'origine bien intentionnés ou délibérément autoritaires, le potentiel d'abus augmente également. En l'absence de surveillance à l'échelle du gouvernement actuellement en place aux États-Unis, le meilleur moyen d'éviter ces abus est d'enseigner au public les usages appropriés de l'IA par le biais de conversations entre scientifiques, les citoyens et les administrateurs publics concernés pour aider à déterminer quand et où il est inapproprié de déployer ces nouveaux outils puissants.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.