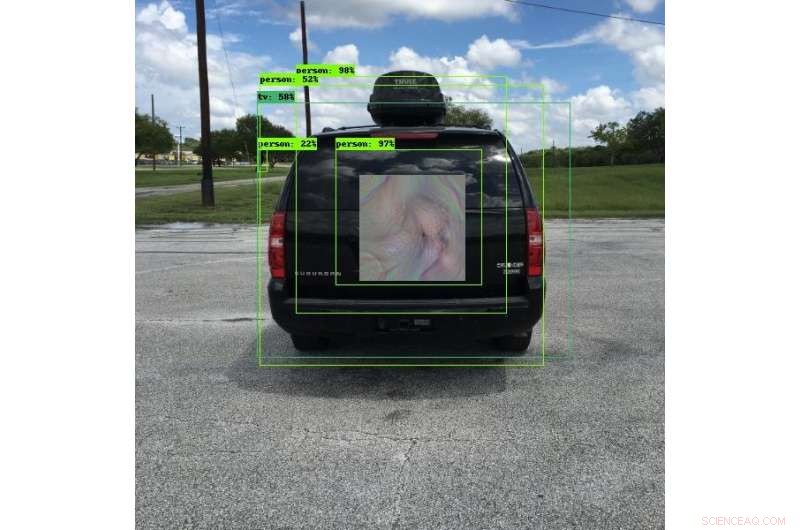

De nombreux véhicules d'aujourd'hui utilisent des systèmes de détection d'objets pour aider à éviter les collisions. Les ingénieurs de SwRI ont développé des modèles uniques qui peuvent amener ces systèmes à voir autre chose, voir les objets dans un autre endroit ou ne pas voir les objets du tout. Dans cette photo, le système de détection d'objets voit une personne plutôt qu'un véhicule. Cette recherche permettra aux ingénieurs de tester en profondeur les systèmes de détection d'objets et d'améliorer la sécurité des algorithmes d'apprentissage en profondeur qu'ils utilisent. Crédit :Institut de recherche du Sud-Ouest

De nouvelles techniques contradictoires développées par les ingénieurs du Southwest Research Institute peuvent rendre les objets « invisibles » pour les systèmes de détection d'images qui utilisent des algorithmes d'apprentissage en profondeur. Ces techniques peuvent également tromper les systèmes en leur faisant croire qu'ils voient un autre objet ou peuvent changer l'emplacement des objets. La technique atténue le risque de compromission dans les systèmes de traitement d'images automatisés.

"Les réseaux de neurones d'apprentissage en profondeur sont très efficaces dans de nombreuses tâches, " déclare l'ingénieur de recherche Abe Garza de la division des systèmes intelligents de SwRI. " Cependant, l'apprentissage en profondeur a été adopté si rapidement que les implications de sécurité de ces algorithmes n'ont pas été pleinement prises en compte."

Les algorithmes d'apprentissage en profondeur excellent dans l'utilisation des formes et des couleurs pour reconnaître les différences entre les humains et les animaux ou les voitures et les camions, par exemple. Ces systèmes détectent de manière fiable les objets dans un éventail de conditions et, En tant que tel, sont utilisés dans une myriade d'applications et d'industries, souvent pour des utilisations critiques pour la sécurité. L'industrie automobile utilise des systèmes de détection d'objets d'apprentissage en profondeur sur les routes pour l'assistance au passage, technologies de sortie de voie et d'évitement des collisions. Ces véhicules s'appuient sur des caméras pour détecter les objets potentiellement dangereux autour d'eux. Si les systèmes de traitement d'images sont vitaux pour la protection des vies et des biens, les algorithmes peuvent être trompés par des parties ayant l'intention de causer des dommages.

Les chercheurs en sécurité travaillant dans l'« apprentissage contradictoire » trouvent et documentent les vulnérabilités des algorithmes d'apprentissage en profondeur et d'autres algorithmes d'apprentissage automatique. En utilisant les fonds de recherche internes de SwRI, Garza et l'ingénieur de recherche principal David Chambers ont développé ce qui semble futuriste, Motifs de style bohème. Lorsqu'il est porté par une personne ou monté sur un véhicule, les modèles trompent les caméras de détection d'objets en leur faisant croire que les objets ne sont pas là, qu'ils sont quelque chose d'autre ou qu'ils sont dans un autre endroit. Des parties malveillantes pourraient placer ces modèles près des routes, créant potentiellement le chaos pour les véhicules équipés de détecteurs d'objets.

Ce qui ressemble à un motif coloré à l'œil humain ressemble à un vélo à un système de détection d'objets. Bien que les algorithmes d'apprentissage en profondeur utilisés dans ces systèmes soient fiables, ils peuvent être trompés avec des images spéciales. Les chercheurs du SwRI développent des techniques pour atténuer le risque de compromission dans ces systèmes. Crédit :Institut de recherche du Sud-Ouest

"Ces modèles amènent les algorithmes de la caméra à mal classer ou à mal localiser les objets, créer une vulnérabilité, " a déclaré Garza. " Nous appelons ces modèles des exemples contradictoires " invariants de perception ", car ils n'ont pas besoin de couvrir l'objet entier ou d'être parallèles à la caméra pour tromper l'algorithme. Les algorithmes peuvent mal classer l'objet tant qu'ils détectent une partie du motif."

Bien qu'ils puissent ressembler à des expositions d'art uniques et colorées à l'œil humain, ces modèles sont conçus de telle manière que les systèmes de caméras de détection d'objets les voient très spécifiquement. Un motif déguisé en publicité à l'arrière d'un bus arrêté pourrait faire croire à un système anticollision qu'il voit un sac à provisions inoffensif à la place du bus. Si la caméra du véhicule ne parvient pas à détecter le véritable objet, il pourrait continuer à avancer et heurter le bus, provoquant une collision potentiellement grave.

"La première étape pour résoudre ces exploits est de tester les algorithmes d'apprentissage en profondeur, " a déclaré Garza. L'équipe a créé un cadre capable de tester à plusieurs reprises ces attaques contre une variété de programmes de détection d'apprentissage en profondeur, ce qui sera extrêmement utile pour tester des solutions.

Les chercheurs du SwRI continuent d'évaluer dans quelle mesure, ou combien peu, du motif est nécessaire pour mal classer ou mal localiser un objet. Travailler avec les clients, cette recherche permettra à l'équipe de tester des systèmes de détection d'objets et, à terme, d'améliorer la sécurité des algorithmes d'apprentissage en profondeur.