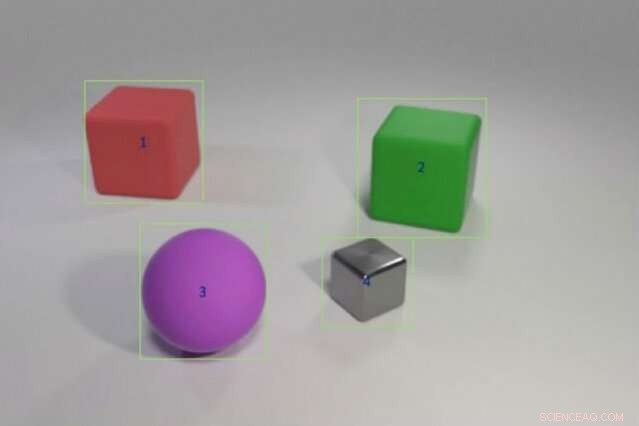

Les chercheurs ont formé un modèle d'IA hybride pour répondre à des questions telles que « L'objet rouge à gauche du cube vert a-t-il la même forme que la chose matte violette ? » en lui fournissant des exemples de couleurs et de formes d'objets suivis de scénarios plus complexes impliquant des comparaisons multi-objets. Le modèle pourrait transférer ces connaissances à de nouveaux scénarios aussi bien ou mieux que les modèles de pointe en utilisant une fraction des données d'entraînement. Crédit :Justin Johnson

Un enfant qui n'a jamais vu d'éléphant rose peut toujours en décrire un, contrairement à un ordinateur. "L'ordinateur apprend des données, " dit Jiajun Wu, un doctorat étudiant au MIT. "La capacité de généraliser et de reconnaître quelque chose que vous n'avez jamais vu auparavant - un éléphant rose - est très difficile pour les machines."

Les systèmes d'apprentissage en profondeur interprètent le monde en sélectionnant des modèles statistiques dans les données. Cette forme de machine learning est désormais partout, en taguant automatiquement des amis sur Facebook, raconter les dernières prévisions météo d'Alexa, et en fournissant des faits amusants via la recherche Google. Mais l'apprentissage statistique a ses limites. Cela nécessite des tonnes de données, a du mal à expliquer ses décisions, et est terrible à appliquer les connaissances passées à de nouvelles situations; Il ne peut pas comprendre un éléphant rose au lieu de gris.

Pour donner aux ordinateurs la capacité de raisonner plus comme nous, les chercheurs en intelligence artificielle (IA) reviennent à l'abstrait, ou symbolique, la programmation. Populaire dans les années 1950 et 1960, des fils d'IA symboliques dans les règles et la logique qui permettent aux machines de faire des comparaisons et d'interpréter la relation entre les objets et les entités. L'IA symbolique utilise moins de données, enregistre la chaîne d'étapes qu'il faut pour parvenir à une décision, et lorsqu'il est combiné avec la puissance de traitement brute des réseaux de neurones statistiques, il peut même battre les humains dans un test de compréhension d'image compliqué.

Une nouvelle étude menée par une équipe de chercheurs du MIT, Laboratoire d'IA MIT-IBM Watson, et DeepMind montre la promesse de fusionner l'IA statistique et symbolique. Dirigé par Wu et Joshua Tenenbaum, professeur au département des sciences du cerveau et des sciences cognitives du MIT et au laboratoire d'informatique et d'intelligence artificielle, l'équipe montre que son modèle hybride peut apprendre des concepts liés aux objets comme la couleur et la forme, et exploiter ces connaissances pour interpréter des relations d'objets complexes dans une scène. Avec un minimum de données d'entraînement et aucune programmation explicite, leur modèle pourrait transférer des concepts à des scènes plus vastes et répondre à des questions de plus en plus délicates aussi bien ou mieux que ses pairs de pointe. L'équipe présente ses résultats lors de la Conférence internationale sur les représentations de l'apprentissage en mai.

"Une façon pour les enfants d'apprendre des concepts est de connecter des mots avec des images, ", déclare l'auteur principal de l'étude, Jiayuan Mao, un étudiant de premier cycle à l'Université Tsinghua qui a travaillé sur le projet en tant que chercheur invité au MIT. "Une machine qui peut apprendre de la même manière a besoin de beaucoup moins de données, et est mieux à même de transférer ses connaissances vers de nouveaux scénarios."

L'étude est un argument de poids pour revenir à des approches de programmes abstraits, dit Jacob Andreas, un récent diplômé de l'Université de Californie à Berkeley, qui commence au MIT en tant que professeur adjoint cet automne et n'a pas été impliqué dans le travail. "L'astuce, il s'avère, est d'ajouter plus de structure symbolique, et de nourrir les réseaux de neurones d'une représentation du monde divisée en objets et propriétés plutôt que de lui fournir des images brutes, " dit-il. " Ce travail nous donne un aperçu de ce que les machines doivent comprendre avant que l'apprentissage des langues ne soit possible. "

L'équipe a formé son modèle sur des images associées à des questions et réponses associées, dans le cadre du test de compréhension d'images CLEVR développé à l'Université de Stanford. Au fur et à mesure que le modèle apprend, les questions deviennent de plus en plus difficiles, de, « Quelle est la couleur de l'objet ? » à « Combien d'objets sont à la fois à droite du cylindre vert et ont le même matériau que la petite boule bleue ? » Une fois les concepts de niveau objet maîtrisés, le modèle avance pour apprendre à lier les objets et leurs propriétés les uns aux autres.

Comme d'autres modèles d'IA hybrides, Le MIT fonctionne en divisant la tâche. Un module de perception de réseaux de neurones analyse les pixels de chaque image et cartographie les objets. Un module de langue, également constitué de réseaux de neurones, extrait un sens des mots de chaque phrase et crée des programmes symboliques, ou instructions, qui indiquent à la machine comment répondre à la question. Un troisième module de raisonnement exécute les programmes symboliques sur la scène et donne une réponse, mettre à jour le modèle lorsqu'il fait des erreurs.

La clé de l'approche de l'équipe est un module de perception qui traduit l'image en une représentation basée sur l'objet, rendre les programmes plus faciles à exécuter. Ce qu'ils appellent l'apprentissage du curriculum est également unique, ou entraîner sélectivement le modèle sur des concepts et des scènes qui deviennent progressivement plus difficiles. Il s'avère que l'alimentation des données de la machine de manière logique, plutôt que par hasard, aide le modèle à apprendre plus rapidement tout en améliorant la précision.

Une fois que le modèle a une base solide, il peut interpréter de nouvelles scènes et concepts, et des questions de plus en plus difficiles, presque parfaitement. Invité à répondre à une question inconnue comme, « Quelle est la forme du gros truc jaune ? » il a surpassé ses pairs de Stanford et du laboratoire voisin du MIT Lincoln avec une fraction des données.

Alors que d'autres modèles se sont entraînés sur l'ensemble de données CLEVR complet de 70, 000 images et 700, 000 questions, le modèle MIT-IBM utilisé 5, 000 images et 100, 000 questions. Comme le modèle s'appuie sur des concepts déjà appris, il a absorbé les programmes sous-jacents à chaque question, accélérer le processus de formation.

Bien que statistique, les modèles de deep learning sont désormais intégrés dans la vie quotidienne, une grande partie de leur processus de décision reste cachée. Ce manque de transparence rend difficile d'anticiper où le système est susceptible de manipulation, Erreur, ou biais. L'ajout d'une couche symbolique peut ouvrir la boîte noire, expliquant l'intérêt croissant pour les systèmes d'IA hybrides.

« Partager la tâche et laisser les programmes faire une partie du travail est la clé pour intégrer l'interprétabilité dans les modèles d'apprentissage en profondeur, " déclare David Mascharka, chercheur au Lincoln Laboratory, dont le modèle hybride, Transparence by Design Network, est étalonné dans l'étude MIT-IBM.

L'équipe MIT-IBM travaille maintenant à améliorer les performances du modèle sur des photos du monde réel et à l'étendre à la compréhension vidéo et à la manipulation robotique. Les autres auteurs de l'étude sont Chuang Gan et Pushmeet Kohli, chercheurs du MIT-IBM Watson AI Lab et DeepMind, respectivement.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.