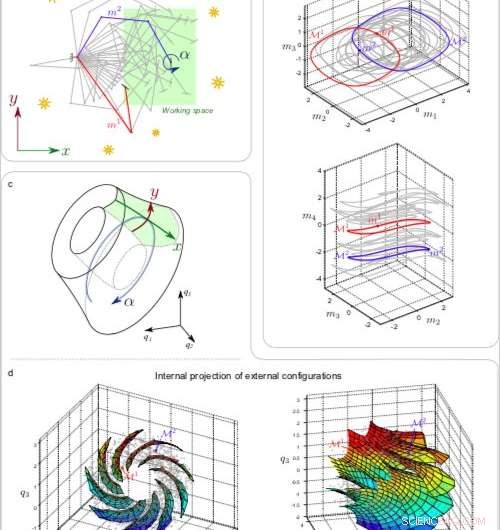

a) 1% des 2500 configurations de bras exploratoires mi . b) Deux projections 3D de 1% des ensembles Mi embarqués dans l'espace moteur 4D. c) Schéma de la variété projetée et capture des paramètres externes. d) Projection en 3D des 2500 variétés Mi (points gris) avec des surfaces correspondant aux translations dans l'espace de travail pour différentes orientations rétiniennes. Crédit :Laflaquière et al.

Des chercheurs de Sorbonne Universités et du CNRS se sont récemment penchés sur les prérequis à l'émergence de notions spatiales simplifiées dans les systèmes robotiques, basé sur le flux sensorimoteur d'un robot. Leur étude, prépublié sur arXiv, fait partie d'un projet plus vaste, dans lequel ils ont exploré comment les notions perceptives fondamentales (par exemple, le corps, espacer, objet, Couleur, etc.) pourraient être instillés dans des systèmes biologiques ou artificiels.

Jusque là, les conceptions des systèmes robotiques ont principalement reflété la façon dont les êtres humains perçoivent le monde. Concevoir des robots guidés uniquement par l'intuition humaine, cependant, pourraient limiter leurs perceptions à celles vécues par les humains.

Concevoir des robots totalement autonomes, les chercheurs pourraient donc avoir besoin de s'éloigner des constructions liées à l'homme, permettant aux agents robotiques de développer leur propre façon de percevoir le monde. Selon l'équipe de chercheurs de Sorbonne Universités et du CNRS, un robot devrait progressivement développer ses propres notions perceptives exclusivement en analysant ses expériences sensorimotrices et en identifiant des modèles significatifs.

"L'hypothèse générale est que personne ne donne de notions perceptives aux organismes biologiques, " Alexandre Terekhov, l'un des chercheurs qui a mené l'étude, a déclaré TechXplore. "Ces concepts sont plutôt développés au fil du temps, comme des outils utiles qui les aident à donner un sens aux vastes données sensorimotrices auxquelles ils sont constamment exposés. En conséquence, la notion d'espace d'une grenouille sera très probablement différente de celle d'une chauve-souris, qui sera à son tour différent de celui des humains. Ainsi, lors de la construction d'un robot, quelle notion d'espace doit-on lui donner ? Probablement aucun de ceux-ci. Si nous voulons que les robots soient vraiment intelligents, il ne faut pas les construire avec des notions abstraites, mais plutôt, leur fournir des algorithmes qui leur permettront de développer eux-mêmes de telles notions."

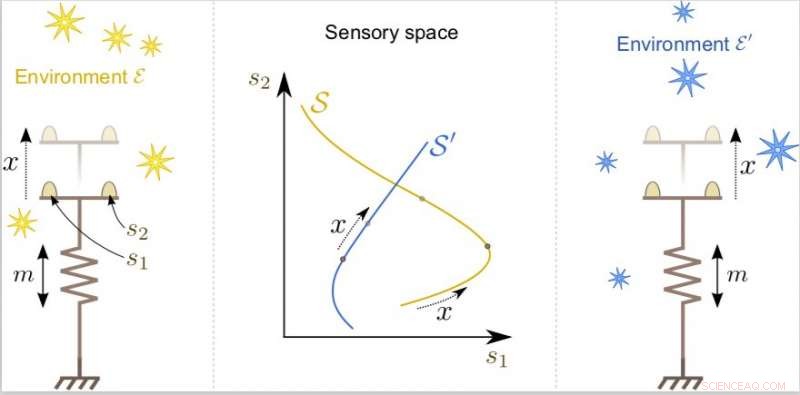

Terekhov et ses collègues ont montré que la notion d'espace comme indépendant de l'environnement ne peut pas être déduite uniquement par des informations extéroceptives, car cette information varie considérablement en fonction de ce qui se trouve dans l'environnement. Cette notion pourrait être mieux définie en examinant les fonctions qui relient les commandes motrices aux changements de stimuli externes à l'agent.

"Un aperçu important est venu d'une ancienne étude du célèbre mathématicien français Henri Poincaré, qui s'intéressait à la façon dont les mathématiques en général et la géométrie en particulier pouvaient émerger de la perception humaine, " a déclaré Terekhov. " Il a suggéré que la coïncidence dans l'entrée sensorielle peut jouer un rôle crucial. "

L'agent peut déplacer ses capteurs dans l'espace extérieur à l'aide de son moteur. Bien que la configuration de l'agent externe x puisse être la même, son expérience sensorielle varie grandement selon la structure de l'environnement. Crédit :Laflaquière et al.

Les idées introduites par Poincaré peuvent être mieux expliquées avec un exemple simple. Quand on regarde un objet donné, les yeux capturent une image particulière, qui changera si l'objet se déplace de 10 cm vers la gauche. Cependant, si on se déplace de 10 cm vers la gauche, l'image que nous voyons restera presque exactement la même.

"Cette propriété semble miraculeuse si vous pensez au nombre de récepteurs que possède le corps humain, " a déclaré Terekhov. " Il est presque impossible d'avoir la même entrée deux fois dans une vie, pourtant nous en faisons constamment l'expérience. Ces événements à faible probabilité peuvent être utilisés par le cerveau pour construire des notions perceptives générales."

Pour appliquer ces idées à la conception de systèmes robotiques, les chercheurs ont programmé un bras robotique virtuel avec une caméra à son extrémité. Le robot notait les mesures provenant des articulations du bras chaque fois qu'il recevait la même entrée visuelle. "En associant toutes ces mesures, le robot construit une abstraction mathématiquement équivalente à la position et à l'orientation de sa caméra, même s'il n'a pas explicitement accès à ces informations, " a déclaré Terekhov. " La chose la plus importante est que même si cette notion abstraite est apprise sur la base de l'entrée visuelle, il finit par en être indépendant, et fonctionne donc pour tous les environnements ; de la même manière, notre notion de l'espace ne dépend pas de la scène particulière que nous voyons."

Appliquant le même principe dans une autre étude, les chercheurs ont réussi à induire un robot à compenser une distorsion optique causée par un objectif placé devant sa caméra. Typiquement, ceci serait atteint par des algorithmes d'apprentissage sur des paires d'images déformées et non déformées.

"La partie délicate de notre étude était que le robot devait accomplir cette tâche en regardant uniquement les images déformées, tout comme les humains apprennent à compenser la distorsion introduite par les lunettes, " a déclaré Terekhov. " Nous pensons que les principes introduits par Poincaré, qui sont la base de nos algorithmes, pourraient être plus généraux et sont utilisés par le cerveau à plusieurs niveaux. Nous explorons actuellement la possibilité d'utiliser ces principes pour construire des réseaux de neurones qui ne souffrent pas d'oubli catastrophique et peuvent progressivement accumuler des connaissances."

© 2018 Tech Xplore