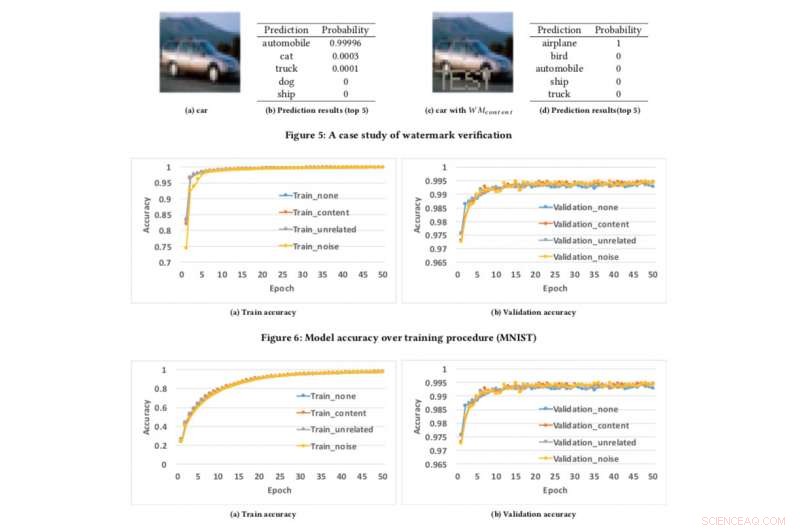

Précision du modèle par rapport à la procédure d'entraînement. Crédit :CIFAR10

Si nous pouvons protéger les vidéos, audio et photos avec filigrane numérique, pourquoi pas des modèles d'IA ?

C'est la question que mes collègues et moi nous sommes posées alors que nous cherchions à développer une technique pour assurer aux développeurs que leur travail acharné dans la construction de l'IA, tels que les modèles d'apprentissage en profondeur, peut être protégé. Vous pensez peut-être, « Protégé de quoi ? » Bien, par exemple, Que faire si votre modèle d'IA est volé ou utilisé à des fins malveillantes, comme offrir un service plagié construit sur un modèle volé ? C'est une préoccupation, en particulier pour les leaders de l'IA comme IBM.

Plus tôt ce mois-ci, nous avons présenté nos recherches à la conférence AsiaCCS '18 à Incheon, République de Corée, et nous sommes fiers de dire que notre technique d'évaluation complète pour relever ce défi s'est avérée très efficace et robuste. Notre innovation clé est que notre concept peut vérifier à distance la propriété des services de réseau de neurones profonds (DNN) à l'aide de simples requêtes API.

À mesure que les modèles d'apprentissage en profondeur sont plus largement déployés et deviennent plus précieux, ils sont de plus en plus ciblés par des adversaires. Notre idée, qui est en instance de brevet, s'inspire des techniques de filigrane populaires utilisées pour le contenu multimédia, telles que des vidéos et des photos.

Lors du filigrane d'une photo, il y a deux étapes :l'intégration et la détection. Dans la phase d'encastrement, les propriétaires peuvent superposer le mot "COPYRIGHT" sur la photo (ou des filigranes invisibles à la perception humaine) et s'il est volé et utilisé par d'autres, nous le confirmons lors de la phase de détection, par lequel les propriétaires peuvent extraire les filigranes comme preuve légale pour prouver la propriété. La même idée peut être appliquée à DNN.

En incorporant des filigranes aux modèles DNN, s'ils sont volés, nous pouvons vérifier la propriété en extrayant les filigranes des modèles. Cependant, différent du tatouage numérique, qui intègre des filigranes dans le contenu multimédia, nous devions concevoir une nouvelle méthode pour intégrer des filigranes dans les modèles DNN.

Dans notre papier, nous décrivons une approche pour infuser des filigranes dans les modèles DNN, et concevoir un mécanisme de vérification à distance pour déterminer la propriété des modèles DNN à l'aide d'appels d'API.

Nous avons développé trois algorithmes de génération de filigrane pour générer différents types de filigranes pour les modèles DNN :

Pour tester notre framework de tatouage, nous avons utilisé deux jeux de données publics :MNIST, un ensemble de données de reconnaissance de chiffres manuscrites qui en compte 60, 000 images d'entraînement et 10, 000 images de test et CIFAR10, un jeu de données de classification d'objets avec 50, 000 images d'entraînement et 10, 000 images de test.

L'exécution de l'expérience est assez simple :nous fournissons simplement au DNN une image spécialement conçue, qui déclenche une réponse inattendue mais contrôlée si le modèle a été tatoué. Ce n'est pas la première fois que le filigrane est envisagé, mais les concepts précédents étaient limités en exigeant l'accès aux paramètres du modèle. Cependant, dans le monde réel, les modèles volés sont généralement déployés à distance, et le service plagié ne publierait pas les paramètres des modèles volés. En outre, les filigranes intégrés dans les modèles DNN sont robustes et résilients aux différents mécanismes de contre-filigrane, comme le réglage fin, élagage des paramètres, et les attaques par inversion de modèle.

Hélas, notre cadre a certaines limites. Si le modèle divulgué n'est pas déployé en tant que service en ligne mais utilisé en tant que service interne, alors nous ne pouvons détecter aucun vol, mais alors bien sûr le plagiaire ne peut pas monétiser directement les modèles volés.

En outre, notre cadre de filigrane actuel ne peut pas protéger les modèles DNN contre le vol via des API de prédiction, où les attaquants peuvent exploiter la tension entre l'accès aux requêtes et la confidentialité des résultats pour apprendre les paramètres des modèles d'apprentissage automatique. Cependant, de telles attaques ne fonctionnent bien en pratique que pour les algorithmes d'apprentissage automatique conventionnels avec moins de paramètres de modèle tels que les arbres de décision et les régressions logistiques.

Nous cherchons actuellement à déployer cela au sein d'IBM et à explorer comment la technologie peut être fournie en tant que service pour les clients.

Cette histoire est republiée avec l'aimable autorisation d'IBM Research. Lisez l'histoire originale ici.