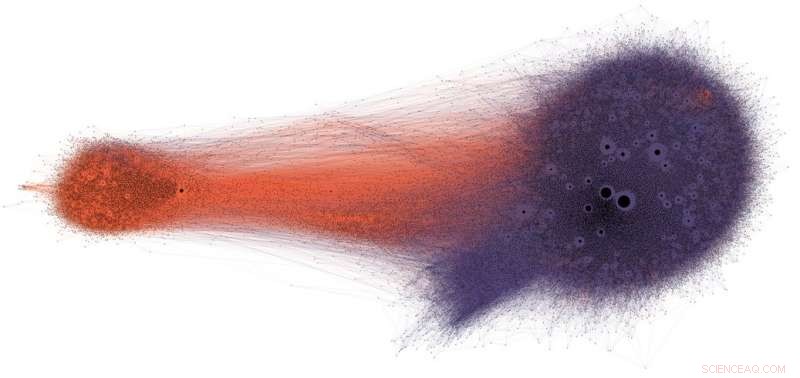

Les personnes qui partagent des informations potentiellement erronées sur Twitter (en violet) voient rarement les corrections ou la vérification des faits (en orange). Crédit :Shao et al., CC BY-ND

Les médias sociaux sont parmi les principales sources d'information aux États-Unis et dans le monde. Pourtant, les utilisateurs sont exposés à des contenus d'une exactitude douteuse, y compris les théories du complot, appât à clics, contenu hyperpartisan, pseudo-science et même fabriqué des rapports de « fausses nouvelles ».

Il n'est pas surprenant qu'il y ait autant de désinformation publiée :le spam et la fraude en ligne sont lucratifs pour les criminels, et la propagande gouvernementale et politique rapporte à la fois des avantages partisans et financiers. Mais le fait que le contenu à faible crédibilité se propage si rapidement et facilement suggère que les personnes et les algorithmes derrière les plateformes de médias sociaux sont vulnérables à la manipulation.

Notre recherche a identifié trois types de biais qui rendent l'écosystème des médias sociaux vulnérable à la désinformation intentionnelle et accidentelle. C'est pourquoi notre Observatoire des médias sociaux à l'Université de l'Indiana construit des outils pour aider les gens à prendre conscience de ces préjugés et à se protéger des influences extérieures conçues pour les exploiter.

Biais dans le cerveau

Les biais cognitifs proviennent de la façon dont le cerveau traite les informations que chaque personne rencontre chaque jour. Le cerveau ne peut traiter qu'une quantité finie d'informations, et trop de stimuli entrants peuvent provoquer une surcharge d'informations. Cela en soi a de sérieuses implications pour la qualité de l'information sur les médias sociaux. Nous avons constaté qu'une forte concurrence pour l'attention limitée des utilisateurs signifie que certaines idées deviennent virales malgré leur faible qualité, même lorsque les gens préfèrent partager du contenu de haute qualité.

Pour éviter d'être débordé, le cerveau utilise un certain nombre d'astuces. Ces méthodes sont généralement efficaces, mais peuvent aussi devenir des préjugés lorsqu'ils sont appliqués dans de mauvais contextes.

Un raccourci cognitif se produit lorsqu'une personne décide de partager ou non une histoire qui apparaît sur son flux de médias sociaux. Les gens sont très affectés par les connotations émotionnelles d'un titre, même si ce n'est pas un bon indicateur de l'exactitude d'un article. Beaucoup plus important est de savoir qui a écrit la pièce.

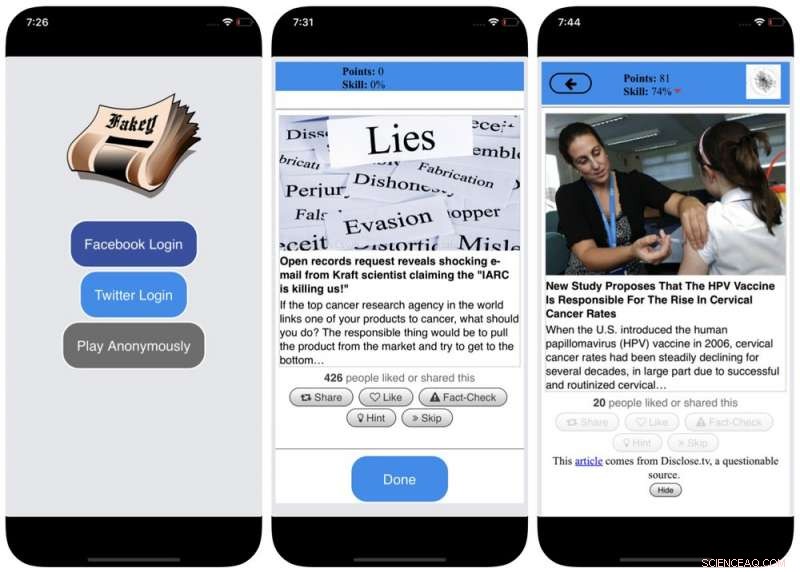

Pour contrer ce biais, et aider les gens à faire plus attention à la source d'une réclamation avant de la partager, nous avons développé Fakey, un jeu de lecture d'actualités sur mobile (gratuit sur Android et iOS) simulant un fil d'actualité typique des réseaux sociaux, avec un mélange d'articles de presse provenant de sources grand public et peu crédibles. Les joueurs obtiennent plus de points pour partager des informations provenant de sources fiables et signaler un contenu suspect pour la vérification des faits. Dans le processus, ils apprennent à reconnaître les signaux de crédibilité de la source, telles que les allégations hyperpartisanes et les gros titres chargés d'émotion.

Biais dans la société

Une autre source de biais vient de la société. Lorsque les gens se connectent directement avec leurs pairs, les préjugés sociaux qui guident leur sélection d'amis en viennent à influencer les informations qu'ils voient.

En réalité, dans notre recherche, nous avons constaté qu'il est possible de déterminer les tendances politiques d'un utilisateur de Twitter en examinant simplement les préférences partisanes de leurs amis. Notre analyse de la structure de ces réseaux de communication partisans a révélé que les réseaux sociaux sont particulièrement efficaces pour diffuser des informations - exactes ou non - lorsqu'ils sont étroitement liés les uns aux autres et déconnectés des autres parties de la société.

La tendance à évaluer plus favorablement les informations si elles proviennent de leurs propres cercles sociaux crée des « chambres d'écho » mûres pour la manipulation, soit consciemment, soit involontairement. Cela aide à expliquer pourquoi tant de conversations en ligne se transforment en confrontations « nous contre eux ».

Captures d'écran du jeu Fakey. Crédit :Mihai Avram et Filippo Menczer

Étudier comment la structure des réseaux sociaux en ligne rend les utilisateurs vulnérables à la désinformation, nous avons construit Hoaxy, un système qui suit et visualise la diffusion de contenus provenant de sources peu crédibles, et comment il rivalise avec le contenu de vérification des faits. Notre analyse des données collectées par Hoaxy lors des élections présidentielles américaines de 2016 montre que les comptes Twitter qui partageaient des informations erronées étaient presque complètement coupés des corrections apportées par les vérificateurs des faits.

Lorsque nous avons approfondi les comptes de diffusion de désinformation, nous avons trouvé un noyau très dense de comptes se retweetant presque exclusivement, y compris plusieurs bots. Les seules fois où les organisations de vérification des faits ont été citées ou mentionnées par les utilisateurs du groupe mal informé, c'était lorsqu'elles remettaient en question leur légitimité ou affirmaient le contraire de ce qu'elles écrivaient.

Biais dans la machine

Le troisième groupe de biais découle directement des algorithmes utilisés pour déterminer ce que les gens voient en ligne. Les plateformes de médias sociaux et les moteurs de recherche les utilisent. Ces technologies de personnalisation sont conçues pour sélectionner uniquement le contenu le plus attrayant et le plus pertinent pour chaque utilisateur. Mais ce faisant, cela peut finir par renforcer les biais cognitifs et sociaux des utilisateurs, les rendant ainsi encore plus vulnérables à la manipulation.

Par exemple, les outils publicitaires détaillés intégrés à de nombreuses plateformes de médias sociaux permettent aux militants de la désinformation d'exploiter le biais de confirmation en adaptant les messages aux personnes qui sont déjà enclines à les croire.

Aussi, si un utilisateur clique souvent sur les liens Facebook d'une source d'actualités particulière, Facebook aura tendance à montrer à cette personne davantage le contenu de ce site. Cet effet dit de « bulle filtrante » peut isoler les gens de divers points de vue, renforcement du biais de confirmation.

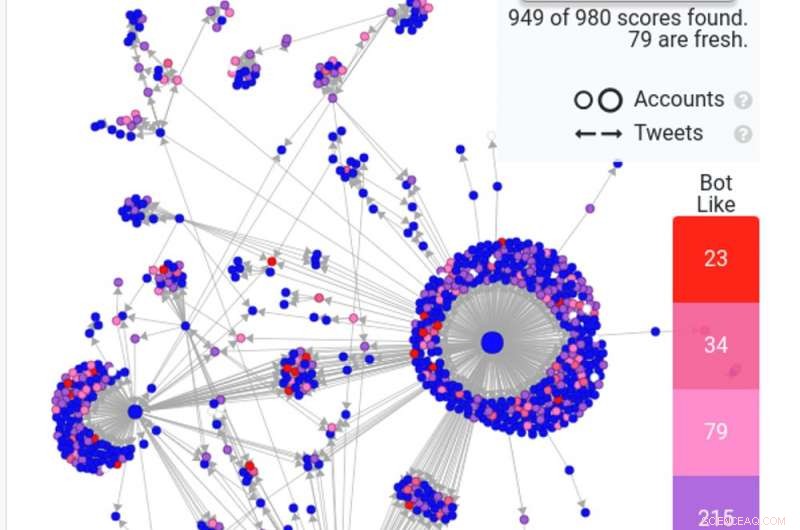

Une capture d'écran d'une recherche Hoaxy montre comment des robots courants - en rouge et rose foncé - propagent une fausse histoire sur Twitter. Crédit:Canular

Nos propres recherches montrent que les plateformes de médias sociaux exposent les utilisateurs à un ensemble de sources moins diversifié que les sites de médias non sociaux comme Wikipédia. Parce que c'est au niveau de toute une plate-forme, pas d'un seul utilisateur, nous appelons cela le biais d'homogénéité.

Un autre ingrédient important des médias sociaux est l'information tendance sur la plate-forme, selon ce qui obtient le plus de clics. Nous appelons ce biais de popularité, car nous avons constaté qu'un algorithme conçu pour promouvoir un contenu populaire peut affecter négativement la qualité globale des informations sur la plate-forme. Cela alimente également les biais cognitifs existants, renforçant ce qui semble être populaire quelle que soit sa qualité.

Tous ces biais algorithmiques peuvent être manipulés par des bots sociaux, programmes informatiques qui interagissent avec les humains via des comptes de médias sociaux. La plupart des robots sociaux, comme Big Ben sur Twitter, sont inoffensifs. Cependant, certains dissimulent leur véritable nature et sont utilisés à des fins malveillantes, comme amplifier la désinformation ou créer faussement l'apparence d'un mouvement populaire, aussi appelé "astroturfing". Nous avons trouvé des preuves de ce type de manipulation à l'approche des élections de mi-mandat de 2010 aux États-Unis.

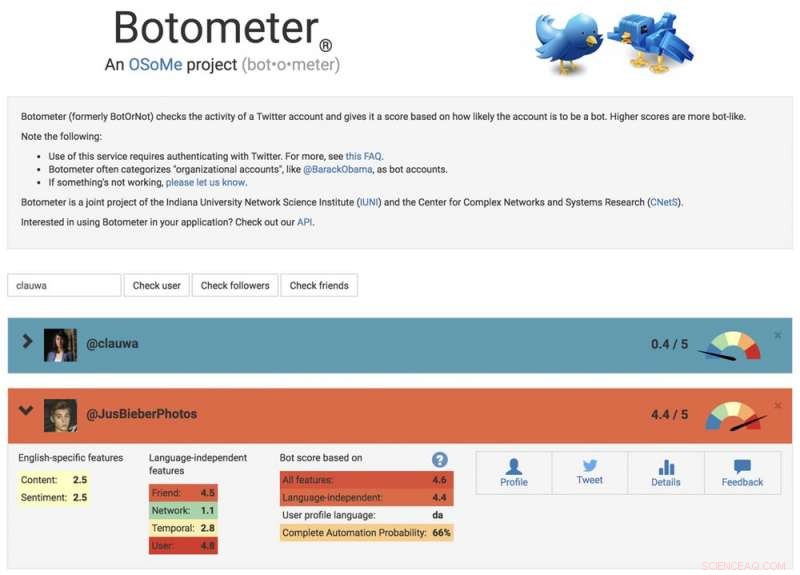

Pour étudier ces stratégies de manipulation, nous avons développé un outil pour détecter les bots sociaux appelé Botometer. Botometer utilise l'apprentissage automatique pour détecter les comptes de bots, en inspectant des milliers de fonctionnalités différentes des comptes Twitter, comme l'heure de ses posts, combien de fois il tweete, et les comptes qu'il suit et retweet. Ce n'est pas parfait, mais il a révélé que jusqu'à 15% des comptes Twitter montrent des signes d'être des bots.

En utilisant Botometer en conjonction avec Hoaxy, nous avons analysé le cœur du réseau de désinformation lors de la campagne présidentielle américaine de 2016. Nous avons trouvé de nombreux bots exploitant à la fois le cognitif, les biais de confirmation et de popularité de leurs victimes et les biais algorithmiques de Twitter.

Ces bots sont capables de construire des bulles de filtrage autour des utilisateurs vulnérables, les nourrir de fausses allégations et de désinformation. D'abord, ils peuvent attirer l'attention des utilisateurs humains qui soutiennent un candidat particulier en tweetant les hashtags de ce candidat ou en mentionnant et retweetant la personne. Ensuite, les bots peuvent amplifier les fausses affirmations diffamant les opposants en retweetant des articles provenant de sources peu crédibles qui correspondent à certains mots-clés. Cette activité permet également à l'algorithme de mettre en évidence pour d'autres utilisateurs de fausses histoires largement partagées.

Une capture d'écran du site Botometer, montrant un compte humain et un compte bot. Crédit :Botomètre

Comprendre les vulnérabilités complexes

Même si nos recherches, et d'autres', montre comment les individus, des institutions et même des sociétés entières peuvent être manipulées sur les réseaux sociaux, il reste beaucoup de questions auxquelles répondre. Il est particulièrement important de découvrir comment ces différents biais interagissent les uns avec les autres, créant potentiellement des vulnérabilités plus complexes.

Des outils comme le nôtre offrent aux internautes plus d'informations sur la désinformation, et donc un certain degré de protection contre ses méfaits. Les solutions ne seront probablement pas seulement technologiques, bien qu'il y ait probablement des aspects techniques. Mais ils doivent prendre en compte les aspects cognitifs et sociaux du problème.

Note de la rédaction :cet article a été mis à jour le 10 janvier 2019, pour supprimer un lien vers une étude qui a été retirée. Le texte de l'article est toujours exact, et reste inchangé.

Cet article a été initialement publié sur The Conversation. Lire l'article original.