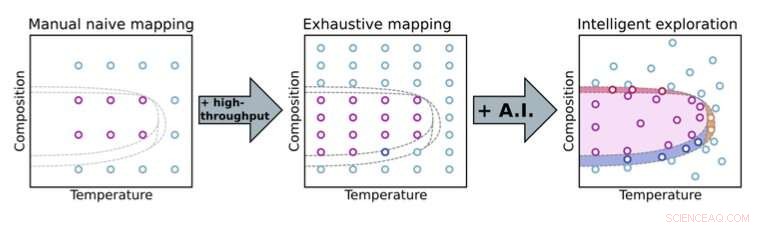

Passer d'une approche d'expérimentation manuelle à une approche d'expérimentation automatisée permet aux scientifiques d'explorer plus en profondeur les espaces paramétriques. Avec des méthodes d'aide à la décision en intelligence artificielle (IA), les scientifiques peuvent se concentrer sur des parties clés de l'espace des paramètres (ici, composition et température) pour une découverte accélérée des matériaux. Crédit :Laboratoire national de Brookhaven

Dans la vision populaire de la science traditionnelle, les scientifiques sont dans le laboratoire en train de planer au-dessus de leurs expériences, microgérer chaque petit détail. Par exemple, ils peuvent tester itérativement une grande variété de compositions de matériaux, les protocoles de synthèse et de traitement, et les conditions environnementales pour voir comment ces paramètres influencent les propriétés des matériaux. A chaque itération, ils analysent les données collectées, rechercher des modèles et s'appuyer sur leurs connaissances scientifiques et leur intuition pour sélectionner des mesures de suivi utiles.

Cette approche manuelle consomme un temps limité de l'instrument et l'attention d'experts humains qui pourraient autrement se concentrer sur la situation dans son ensemble. Les expériences manuelles peuvent également être inefficaces, surtout quand il y a un grand nombre de paramètres à explorer, et sont soumis à des préjugés humains, par exemple, pour décider quand on a collecté suffisamment de données et qu'on peut arrêter une expérience. La manière conventionnelle de faire de la science ne peut pas évoluer pour gérer l'énorme complexité des futurs défis scientifiques. Les progrès des instruments scientifiques et des capacités d'analyse des données dans les installations expérimentales continuent de permettre des mesures plus rapides. Bien que ces avancées puissent aider les scientifiques à s'attaquer à des problèmes expérimentaux complexes, ils exacerbent également le goulot d'étranglement humain; aucun humain ne peut suivre les outils expérimentaux modernes !

Envisager l'automatisation

La National Synchrotron Light Source II (NSLS-II) du laboratoire national de Brookhaven du département américain de l'Énergie (DOE) est l'une de ces installations gérant ces types de défis. En dirigeant des faisceaux lumineux, allant de l'infrarouge aux rayons X durs, vers des échantillons aux stations expérimentales (lignes de lumière), NSLS-II peut révéler l'électronique, chimique, et les structures atomiques des matériaux. Lorsque les scientifiques conçoivent ces lignes de lumière il y a dix ans, ils ont eu la prévoyance d'intégrer l'automatisation permise par l'apprentissage automatique (ML) et l'intelligence artificielle (IA) - désormais un domaine en pleine explosion - dans le cadre de leur vision.

"Nous pensions, ne serait-il pas formidable si les scientifiques pouvaient non seulement effectuer des mesures plus rapidement, mais également effectuer une exploration intelligente, c'est-à-dire explorer les problèmes scientifiques de manière plus intelligente, des moyens plus efficaces en tirant parti des méthodes informatiques modernes, " a déclaré Kevin Yager, chef du groupe des nanomatériaux électroniques du Center for Functional Nanomaterials (CFN) du Brookhaven Lab. "En réalité, au CFN, nous avons défini l'un de nos thèmes de recherche comme étant la découverte accélérée de nanomatériaux. »

Cette idée d'une ligne de lumière hautement automatisée qui pourrait explorer intelligemment les problèmes scientifiques a fini par devenir un objectif à long terme de la ligne de lumière à diffusion de matériaux complexes (CMS), développé et exploité par une équipe dirigée par Masafumi Fukuto.

« Nous avons commencé par développer des capacités à haut débit pour des mesures rapides, comme un robot d'échange d'échantillons et de nombreux outils in-situ pour explorer différents paramètres tels que la température, la pression de vapeur, et l'humidité, " dit Fukuto. " En même temps, nous avons commencé à penser à automatiser non seulement le matériel de la ligne de lumière pour la collecte de données, mais également l'analyse de données en temps réel et la prise de décision expérimentale. La capacité de prendre des mesures très rapidement est utile et nécessaire mais pas suffisante pour la découverte de matériaux révolutionnaires car les espaces de paramètres de matériaux sont très grands et multidimensionnels. »

Par exemple, une expérience peut avoir un espace de paramètres avec cinq dimensions et plus de 25, 000 points distincts dans cet espace à explorer. Le logiciel d'acquisition et d'analyse de données pour faire face à ces grands, des espaces paramétriques de grande dimension ont été construits en interne à Brookhaven. Pour la collecte de données, ils ont construit sur le logiciel Bluesky, que NSLS-II a développé. Pour analyser les données, Yager a écrit le code d'un logiciel d'analyse d'images appelé SciAnalysis.

Fermer la boucle

En 2017, Fukuto et Yager ont commencé à collaborer avec Marcus Noack, puis un post-doctorant et maintenant un chercheur scientifique au Center for Advanced Mathematics for Energy Research Applications (CAMERA) au Lawrence Berkeley National Laboratory du DOE. Pendant son séjour en post-doctorat, Noack a été chargé de collaborer avec l'équipe de Brookhaven sur leur concept de ligne de lumière autonome. Spécifiquement, ils ont travaillé ensemble pour développer la dernière pièce pour créer une configuration expérimentale entièrement automatisée :un algorithme de prise de décision. L'équipe de Brookhaven a défini ses besoins, tandis que Noack a fourni son expertise en mathématiques appliquées et a écrit le logiciel pour répondre à ces besoins.

En tirant parti de l'IA et du ML, cet algorithme détermine les meilleures prochaines mesures à effectuer pendant qu'une expérience est en cours. (L'IA fait référence à une machine simulant le comportement humain, tandis que ML est un sous-domaine de l'IA dans lequel une machine apprend automatiquement à partir de données passées.) Pour que l'algorithme commence à modéliser un système, c'est aussi simple qu'un utilisateur définissant les entrées et les sorties :quelles sont les variables que je peux contrôler dans l'expérience, et qu'est-ce que je vais mesurer? Mais plus les humains fournissent d'informations à l'avance, telles que la réponse attendue du système ou les contraintes connues basées sur le problème particulier étudié, plus la modélisation sera robuste. Dans les coulisses, un processus gaussien est à l'œuvre pour modéliser le comportement du système.

"Un processus gaussien est un moyen mathématiquement rigoureux d'estimer l'incertitude, " a expliqué Yager. " C'est une autre façon de dire la connaissance dans mon esprit. Et c'est une autre façon de dire science. Parce qu'en sciences, c'est ce qui nous intéresse le plus :qu'est-ce que je sais, et est-ce que je le sais bien ?"

"C'est la partie ML, " a ajouté Fukuto. " L'algorithme va un peu plus loin. Il prend automatiquement des décisions sur la base de ces connaissances et des intrants humains pour sélectionner le point qui aurait du sens à mesurer ensuite. »

Dans un cas simpliste, cette prochaine mesure serait l'emplacement dans l'espace des paramètres où le gain d'information peut être maximisé (ou l'incertitude réduite). L'équipe a démontré pour la première fois cette preuve de concept en 2019 sur la ligne de lumière CMS NSLS-II, imager un film de nanomatériau réalisé spécifiquement pour cette démonstration.

Depuis ce premier succès, l'équipe a rendu l'algorithme plus sophistiqué, l'appliquer pour étudier un large éventail de problèmes scientifiques réels (plutôt que artificiels) de divers groupes, et l'étendre à des techniques et des installations plus expérimentales.

Alors que la version par défaut de l'algorithme vise à minimiser l'incertitude ou à maximiser le gain de connaissances de manière itérative, il existe d'autres façons de réfléchir à l'endroit où concentrer l'attention expérimentale pour obtenir le plus de valeur. Par exemple, pour certains scientifiques, le coût de l'expérience, qu'il s'agisse de sa durée ou de la quantité de matériaux utilisés, est important. En d'autres termes, ce n'est pas seulement où vous prenez les données mais comment cher c'est de prendre ces données. D'autres peuvent trouver utile de se concentrer sur des fonctionnalités spécifiques, telles que les limites dans un espace de paramètres ou la taille des grains d'un cristal. Le plus sophistiqué, La version flexible de l'algorithme développé par Noack peut être programmée pour avoir une sensibilité accrue à ces fonctionnalités.

"Vous pouvez affiner vos objectifs dans l'expérience, " expliqua Yager. " Alors, cela peut être un gain de connaissances, ou un gain de connaissances régulé par le coût expérimental ou associé à des fonctionnalités spécifiques.

D'autres améliorations incluent la capacité de l'algorithme à gérer la complexité des systèmes réels, comme le fait que les matériaux ne sont pas homogènes, ce qui signifie qu'ils ne sont pas les mêmes à chaque point d'un échantillon. Une partie d'un échantillon peut avoir une composition uniforme, tandis qu'un autre peut avoir une composition variable. De plus, l'algorithme prend maintenant en compte l'anisotropie, ou comment les paramètres individuels peuvent être très différents les uns des autres en termes de la façon dont ils affectent un système. Par exemple, "x" et "y" sont des paramètres équivalents (ce sont tous deux des coordonnées de position) mais pas la température et la pression.

"Les processus gaussiens utilisent des noyaux - des fonctions qui décrivent comment les points de données dépendent les uns des autres dans l'espace - pour l'interpolation, " dit Noack. " Les noyaux ont toutes sortes de propriétés mathématiques intéressantes. Par exemple, ils peuvent coder divers degrés d'inhomogénéité pour un échantillon. »

Accroître la sophistication de l'algorithme n'est qu'une partie du défi. Puis, Fukuto et Yager doivent intégrer l'algorithme mis à jour dans le flux de travail expérimental automatisé en boucle fermée et le tester sur différentes expériences, non seulement celles réalisées en interne, mais également celles réalisées par les utilisateurs.

Déployer la méthode auprès de la communauté scientifique au sens large

Récemment, Fukuto, Yager, Noack, et ses collègues ont déployé la méthode autonome dans plusieurs expériences réelles sur diverses lignes de lumière NSLS-II, y compris CMS et Soft Matter Interfaces (SMI). Noack et ses collaborateurs ont également déployé la méthode à l'Advanced Light Source (ALS) du LBNL et à l'Institut Laue-Langevin (ILL), une installation de diffusion de neutrons en France. L'équipe a sorti son logiciel d'aide à la décision, gpCAM, à la communauté scientifique au sens large afin que chacun puisse mettre en place ses propres expériences autonomes.

Dans une expérience, en collaboration avec l'U.S. Air Force Research Laboratory (AFRL), ils ont utilisé la méthode dans une expérience autonome de diffusion des rayons X en synchrotron sur la ligne de lumière CMS. En diffusion des rayons X, les rayons X rebondissent sur un échantillon dans différentes directions selon la structure de l'échantillon. Le premier objectif de l'expérience était d'explorer comment la structure ordonnée des films composites nanotige-polymère dépend de deux paramètres de fabrication :la vitesse de revêtement du film et le revêtement chimique du substrat. Le deuxième objectif était d'utiliser ces connaissances pour localiser et cibler les régions des films avec les degrés d'ordre les plus élevés.

« Ces matériaux présentent un intérêt pour les revêtements optiques et les capteurs, " a expliqué Ruipeng Li, scientifique de la ligne de lumière de CMS. " Nous avons utilisé une méthode de fabrication particulière qui imite les processus industriels de rouleau à rouleau pour trouver la meilleure façon de former ces films commandés en utilisant des processus industriellement évolutifs. "

Dans une autre expérience de diffusion des rayons X, à la ligne de lumière SMI, l'algorithme a réussi à identifier des régions d'ordre inattendu dans un espace de paramètres pertinent pour l'auto-assemblage de films de copolymères séquencés. Les copolymères séquencés sont des polymères constitués de deux ou plusieurs "blocs" chimiquement distincts liés ensemble. En identifiant ces caractéristiques, l'expérience autonome a mis en lumière un problème avec la méthode de fabrication.

"Ce n'était pas hypothétique, nous travaillons sur ce projet depuis de nombreuses années, ", a déclaré Gregory Doerk, scientifique des matériaux du CFN. "Nous avions répété à l'ancienne, faire des expériences, prendre des images à des endroits que nous avons choisis arbitrairement, en regardant les images, et d'être perplexe quant à ce qui se passe. Avec l'approche autonome, en une journée d'expériences sur la ligne de lumière, nous avons pu trouver les défauts et les corriger immédiatement au tour suivant. C'est une accélération spectaculaire du cycle normal de la recherche où vous faites une étude, découvrir que cela n'a pas fonctionné, et retournez à la planche à dessin."

Noack et ses collaborateurs ont également appliqué la méthode à un autre type de technique aux rayons X appelée cartographie infrarouge synchrotron autonome, qui peut fournir des informations chimiques sur un échantillon. Et ils ont démontré comment la méthode pouvait être appliquée à une technique de spectroscopie pour découvrir de manière autonome des phases où les électrons se comportent de manière fortement corrélée et à la diffusion de neutrons pour mesurer de manière autonome les corrélations magnétiques.

Façonner l'avenir de l'expérimentation autonome

Selon Yager, leur méthode peut être appliquée à toute technique pour laquelle la collecte et l'analyse des données sont déjà automatisées. L'un des avantages de l'approche est qu'elle est « agnostique de la physique, " ce qui signifie qu'il n'est lié à aucun type de matériel particulier, problème physique, ou technique. Les quantités physiquement significatives pour la prise de décision sont extraites grâce à l'analyse des données brutes.

"Nous voulions rendre notre approche très générale afin qu'elle puisse être appliquée à n'importe quoi et ensuite adaptée à des problèmes spécifiques, " a déclaré Yager. " En tant qu'installation d'utilisateur, nous voulons permettre au plus grand nombre de personnes de faire de la science intéressante."

À l'avenir, l'équipe ajoutera des fonctionnalités permettant aux utilisateurs d'intégrer la sensibilisation à la physique, ou des connaissances sur les matériaux ou les phénomènes qu'ils étudient, s'ils le désirent. Mais l'équipe le fera d'une manière qui ne détruira pas la flexibilité générale de l'approche; les utilisateurs pourront activer ou désactiver ces connaissances supplémentaires.

Un autre aspect des travaux futurs est l'application de la méthode pour contrôler les processus en temps réel - en d'autres termes, contrôler un système qui évolue dynamiquement dans le temps au fur et à mesure qu'une expérience se déroule.

"Jusqu'à ce point, nous nous sommes concentrés sur la prise de décisions sur la façon de mesurer ou de caractériser les systèmes de matériaux préparés, " a déclaré Fukuto. "Nous voulons également prendre des décisions sur la façon de changer les matériaux ou sur les types de matériaux que nous voulons fabriquer. Comprendre la science fondamentale derrière les changements matériels est important pour améliorer les processus de fabrication."

Réaliser cette capacité à explorer intelligemment des matériaux évoluant en temps réel nécessitera de surmonter des défis algorithmiques et d'instrumentation.

"La prise de décision doit être très rapide, et vous devez créer des environnements d'échantillonnage pour faire la synthèse des matériaux en temps réel pendant que vous prenez des mesures avec un faisceau de rayons X, " expliqua Yager.

Malgré ces défis, l'équipe est enthousiasmée par l'avenir de l'expérimentation autonome.

"Nous avons commencé cet effort à très petite échelle, mais c'est devenu quelque chose de beaucoup plus grand, " dit Fukuto. " Beaucoup de gens s'y intéressent, pas seulement nous. La communauté d'utilisateurs s'est élargie, et avec des utilisateurs étudiant différents types de problèmes, cette approche pourrait avoir un grand impact sur l'accélération d'une multitude de découvertes scientifiques."

« Cela représente un très grand changement dans la façon de penser de passer de l'ancienne méthode de microgestion des expériences à cette nouvelle vision des systèmes automatisés exécutant des expériences avec des humains les orchestrent à un très haut niveau parce qu'ils comprennent ce qui doit être fait et ce que la science signifie, " a déclaré Yager. " C'est une vision très excitante pour l'avenir de la science. Nous allons pouvoir nous attaquer à des problèmes à l'avenir qu'il y a 10 ans, les gens auraient dit impossibles."