Crédit :CC0 Domaine public

La révolution des micro-ordinateurs des années 1970 a déclenché une expansion des ordinateurs personnels semblable au Far West dans les années 1980. Au cours de la décennie, des dizaines d'appareils informatiques personnels, d'Atari à Xerox Alto, inondé le marché. Les processeurs et les microprocesseurs ont évolué rapidement, avec les nouvelles générations qui sortent tous les mois.

Au milieu de toute cette croissance, il n'y avait pas de méthode standard pour comparer les performances d'un ordinateur par rapport à un autre. Sans cela, non seulement les consommateurs ne savaient pas quel système était le mieux adapté à leurs besoins, mais les concepteurs d'ordinateurs n'avaient pas de méthode standard pour tester leurs systèmes.

Cela a changé en 1988, lorsque la Standard Performance Evaluation Corporation (SPEC) a été créée pour produire, maintenir et approuver un ensemble normalisé de références de performance pour les ordinateurs. Pensez à des références comme des tests standardisés pour les ordinateurs. Comme les SAT ou le TOEFL, les repères sont destinés à fournir une méthode de comparaison entre des participants similaires en leur demandant d'effectuer les mêmes tâches.

Depuis la SPEC, des dizaines d'organisations d'analyse comparative ont vu le jour pour fournir une méthode de comparaison des performances de divers systèmes sur différentes architectures de puces et de programmes.

Aujourd'hui, il y a un nouveau Far West dans l'apprentissage automatique. Actuellement, il existe au moins 40 sociétés de matériel différentes prêtes à innover dans de nouvelles architectures de processeurs d'IA.

"Certaines de ces entreprises vont monter mais beaucoup vont tomber, " a déclaré Vijay Janapa Reddi, Professeur agrégé de génie électrique à la Harvard John A. Paulson School of Engineering and Applied Sciences (SEAS). "Le défi est de savoir comment savoir si un matériel est meilleur qu'un autre ? C'est là que les normes de référence deviennent importantes."

Janapa Reddi est l'un des dirigeants de MLPerf, une suite d'analyse comparative d'apprentissage automatique. ML Perf a commencé comme une collaboration entre des chercheurs de Baidu, Berkeley, Google, Harvard, et Stanford et a grandi pour inclure de nombreuses entreprises, une multitude d'universités, ainsi que des centaines de participants individuels dans le monde entier. Les autres contributeurs de Harvard incluent David Brooks, le professeur d'informatique de la famille Haley à SEAS et Gu-Yeon Wei, le professeur Robert et Suzanne Case de génie électrique et d'informatique à SEAS.

L'objectif de ML Perf est de créer une référence pour mesurer les performances des frameworks logiciels de machine learning, accélérateurs matériels d'apprentissage automatique, et les plates-formes d'informatique en nuage et de périphérie d'apprentissage automatique.

Nous avons parlé à Janapa Reddi de MLPerf et de l'avenir de l'analyse comparative pour l'apprentissage automatique.

MER :D'abord, comment fonctionne l'analyse comparative pour l'apprentissage automatique ?

Janapa Reddi :Dans sa forme la plus simple, une norme de référence est une définition stricte d'une tâche d'apprentissage automatique, disons la classification d'images. En utilisant un modèle qui implémente cette tâche, tels que ResNet50, et un jeu de données, comme COCO ou ImageNet, le modèle est évalué avec une précision cible ou une métrique de qualité qu'il doit atteindre lorsqu'il est exécuté avec l'ensemble de données.

SEAS :Comment l'analyse comparative est-elle prise en compte dans vos recherches chez SEAS ?

Janapa Reddi :Personnellement, Je suis intéressé par le benchmark de systèmes d'apprentissage automatique autonomes et "minuscules".

Les véhicules autonomes s'appuient fortement sur l'apprentissage automatique pour le traitement de la vision, fusion de capteurs et plus encore. Le coffre d'une voiture autonome en contient plus de 2, 500 watts de puissance de calcul. Juste pour remettre ça en contexte, un smartphone consomme 3 Watts, et votre ordinateur portable moyen utilise 25 watts. Ces véhicules autonomes consomment donc une quantité importante d'énergie, grâce en partie à tout l'apprentissage automatique sur lequel ils s'appuient. My Edge Computing Lab souhaite réduire cette consommation d'énergie, tout en repoussant les limites de toutes les capacités de traitement nécessaires, apprentissage automatique et tout inclus.

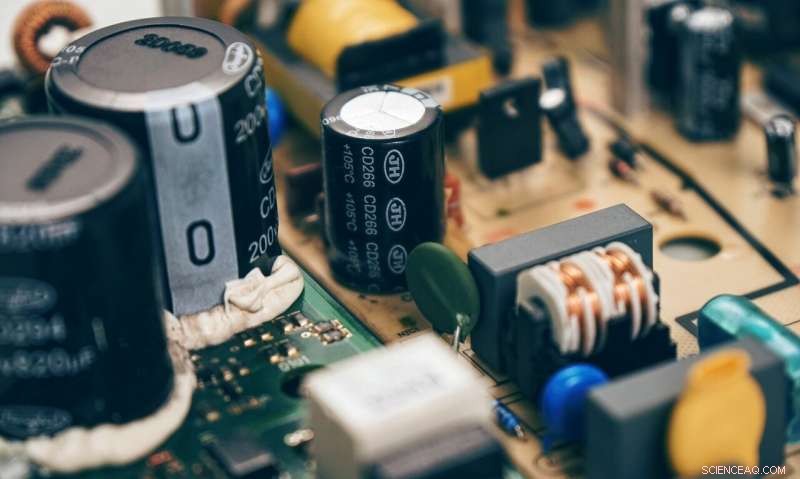

À l'autre extrémité du spectre se trouvent les « petits » appareils. Pensez à de minuscules microcontrôleurs qui consomment des milliwatts de puissance qui peuvent être jetés et oubliés. Les microcontrôleurs minuscules d'aujourd'hui sont des dispositifs passifs avec peu ou pas d'intelligence embarquée. Mais "TinyML" est un concept émergent qui se concentre sur l'apprentissage automatique pour de minuscules microcontrôleurs embarqués. Mon groupe étudie comment nous pouvons activer TinyML car nous voyons de nombreuses utilisations diverses. Les appareils TinyML peuvent surveiller votre santé intelligemment, ou de minuscules drones qui tiennent dans votre paume peuvent naviguer dans de petits espaces restreints en cas de chute d'un bâtiment pour les opérations de recherche et de sauvetage, et voler entre les arbres et les feuilles pour surveiller la santé des cultures des agriculteurs et empêcher les parasites d'entrer

Ce sont deux domaines qui m'intéressent beaucoup, spécifiquement dans le contexte des systèmes d'apprentissage automatique, car il existe plusieurs problèmes de recherche intéressants à résoudre qui vont au-delà des performances matérielles de l'apprentissage automatique et incluent la conception et la mise en œuvre du logiciel du système d'apprentissage automatique.

SEAS :Quelles leçons l'apprentissage automatique peut-il tirer des précédents efforts d'analyse comparative ? comme celles lancées par SPEC il y a trois décennies ?

Janapa Reddi :Au fil des ans, SPEC CPU a été piloté par un consortium de différents partenaires de l'industrie qui se réunissent pour déterminer une suite de charges de travail pouvant conduire à des résultats d'analyse comparative justes et utiles. D'où, Les charges de travail SPEC sont devenues une norme dans la recherche et le milieu universitaire pour mesurer et comparer les performances du processeur. Comme David Patterson, architecte informatique renommé et lauréat du prix Turing 2017, aime souvent à le souligner, Les charges de travail SPEC ont conduit à l'âge d'or de la conception des microprocesseurs.

Nous pouvons emprunter quelques leçons de SPEC et les appliquer à l'apprentissage automatique. Nous devons réunir la communauté universitaire et de recherche pour créer un consortium similaire de partenaires industriels qui peuvent aider à définir des normes et des références représentatives de cas d'utilisation réels.

SEAS :C'est ainsi que fonctionne ML Perf ?

Janapa Reddi :Oui. MLPerf est l'effort de nombreuses organisations et de plusieurs individus engagés, tous travaillant ensemble avec la même vision cohérente de construire une référence juste et utile pour les systèmes d'apprentissage automatique. Grâce à cet effort d'équipe, nous proposons des références basées sur la sagesse de nombreuses personnes et une compréhension approfondie des cas d'utilisation des clients dans le monde réel. Les ingénieurs travaillant sur des systèmes d'apprentissage automatique apportent leurs expériences sur les problèmes de systèmes nuancés et les entreprises peuvent fournir leurs cas d'utilisation réels (avec la permission de l'utilisateur, bien sûr). Sur la base de toutes les informations que nous recueillons, l'équipe collaborative de chercheurs et d'ingénieurs MLPerf organise une référence utile pour les plates-formes et les systèmes d'apprentissage.

SEAS :MLPerf vient d'annoncer de nouvelles références pour l'apprentissage automatique, droit?

Janapa Reddi :Exact. Nous venons d'annoncer notre première suite d'inférence, qui se compose de cinq points de référence sur trois tâches d'apprentissage automatique différentes :classification d'images, détection d'objets et traduction automatique. Ces trois tâches incluent des modèles bien connus comme MobileNets et ResNet qui prennent en charge différentes résolutions d'image pour différents cas d'utilisation comme les véhicules autonomes et les smartphones.

Nous stimulons les modèles avec le "LoadGen, " qui est un générateur de charge qui imite différents modes de cas d'utilisation trouvés dans le monde réel. Par exemple, dans les smartphones, on prend une photo, l'intégrer dans un modèle d'apprentissage automatique, et attendons avec impatience de voir s'il peut identifier quelle est l'image. Évidemment, nous voulons que cette inférence soit aussi rapide que possible. Dans un système de surveillance par caméra, nous voulons regarder plusieurs images provenant de différentes caméras, le cas d'utilisation est donc sensible à la fois à la latence et au débit (combien d'images puis-je traiter dans un laps de temps limité). Ce LoadGen avec nos benchmarks distingue MLPerf des autres benchmarks.

MER :Alors, que ce passe t-il après?

Janapa Reddi :Les benchmarks sont un pas vers un objectif plus ambitieux. MLPerf souhaite étendre ses efforts de la conservation de références pour l'évaluation des performances du système au développement de nouveaux ensembles de données pouvant favoriser de nouvelles innovations dans les algorithmes d'apprentissage automatique, communautés logicielles et matérielles. Jusqu'ici, nous nous sommes appuyés sur des ensembles de données qui ont été largement rendus accessibles via des universitaires des communautés open source. Mais dans certains domaines, comme la parole, il existe un réel besoin de développer de nouveaux ensembles de données au moins 10 à 100 fois plus volumineux. Mais plus grand seul est insuffisant. Nous devons également aborder l'équité et le manque de diversité dans les ensembles de données pour garantir que les modèles qui sont formés sur ces ensembles de données sont impartiaux

SEAS :Comment abordez-vous l'équité et la diversité dans l'apprentissage automatique ?

Janapa Reddi :Nous avons créé « Harvard MLPerf Research » en collaboration avec le Center for Research on Computation and Society (CRCS), qui rassemble des scientifiques et des universitaires de divers domaines pour faire avancer la recherche informatique au service de l'intérêt public. Par le centre, nous espérons entrer en contact avec les experts d'autres écoles pour aborder des questions telles que l'équité et les biais dans les ensembles de données. Nous avons besoin de plus que des informaticiens pour résoudre ces problèmes.