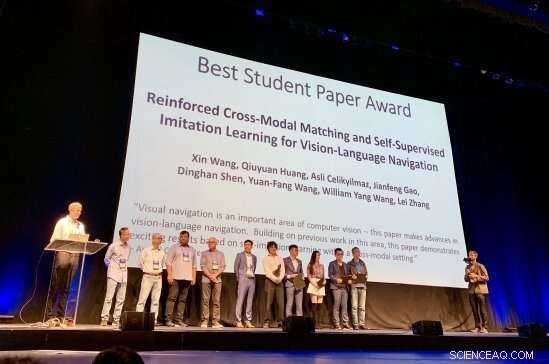

Les chercheurs à l'origine du CVPR Best Student Paper Award 2019 sont reconnus pour leur travail Crédit : Matthew Turk

Neuf mille deux cents chercheurs en intelligence artificielle. Cinq mille cent soixante-cinq articles de recherche soumis, dont seulement 1, 300 ont été acceptés. Un meilleur papier étudiant.

Et le prix a été décerné à :Xin Wang, doctorant en informatique à l'UC Santa Barbara. Son journal étudiant, « Correspondance intermodale renforcée et apprentissage par imitation auto-supervisé pour la navigation dans le langage visuel, " a émergé n ° 1 dans sa catégorie à la 31e conférence IEEE/CVF sur la vision par ordinateur et la reconnaissance de formes (CVPR), l'une des conférences les plus importantes dans le domaine de l'informatique aujourd'hui. La cérémonie de remise des prix a eu lieu à Long Beach, mardi, 18 juin.

"Xin a commencé à travailler avec moi en 2017 en tant que doctorant sur des sujets liés à la recherche sur le langage et la vision, " dit William Wang, professeur adjoint au Département d'informatique du Collège d'ingénierie de l'UCSB. « Depuis mars 2018, nous avons étudié le problème de navigation vision-langage :comment utilisez-vous des instructions verbales pour apprendre aux robots à cibler des destinations ? sans accès à une carte ?"

Un robot qui peut naviguer en fonction de la vision et effectuer des tâches selon des instructions dans un langage ordinaire ressemble à de la science-fiction, mais c'est plus proche de la réalité que vous ne le pensez.

"Je travaille depuis un moment sur l'intersection de la vision et du langage, " Xin Wang a dit, "et je crois que l'un des grands mouvements de l'IA est de faire interagir les robots avec le monde visuel et physique, notamment via le langage naturel.

« La navigation en langage visuel peut permettre de nombreuses applications pratiques, par exemple, robots à domicile, " continua-t-il. " Tout le monde, surtout les handicapés, peut demander au robot d'effectuer certaines tâches, par exemple 'Allez à la cuisine et apportez-moi une tasse d'eau.' La navigation en langage visuel sert de tâche de base pour comprendre à la fois les scènes visuelles et les instructions en langage naturel, ainsi que d'effectuer des actions physiques pour remplir des emplois de haut niveau."

Mais ce qui vient si naturellement aux gens - naviguer dans une scène et effectuer des tâches à l'aide d'indices environnementaux en temps réel et de concepts humains - nécessite une approche flexible, cadre pourtant élégant dans lequel les robots peuvent apprendre à relier les données qu'ils récupèrent à la signification des instructions qu'ils reçoivent. C'est un processus itératif, nécessitant un renforcement, rétroaction et adaptation. Le travail de Xin Wang, selon son conseiller, "présente plusieurs idées innovantes pour améliorer la généralisation de l'algorithme de navigation en langage vision."

"Cette percée dans la recherche sur le langage et la vision permettra aux robots de mieux assister les humains dans de nombreuses routines quotidiennes et spéciales, y compris le nettoyage et l'entretien de la maison, recherche et récupération d'objets, télécommande, aider les personnes aveugles, secours aux sinistrés, etc, " William Wang a déclaré. " Il a le potentiel d'influencer des millions de personnes et d'améliorer la qualité de vie des humains, notamment libérer les humains des tâches ménagères fastidieuses, afin que nous puissions prendre du temps pour des activités créatives. »

La recherche pour le CVPR Best Student Paper 2019, qui s'appuie sur des collaborations antérieures à l'UCSB sur l'apprentissage par renforcement basé sur un modèle et sans modèle avec un doctorat. étudiant Wenhan Xiong, a été réalisée à l'été 2018 lors d'un stage chez Microsoft Research (MSR), sous les mentors Qiuyuan Huang, Asli Celikyilmaz, Jianfeng Gao et Lei Zhang.

Selon le comité CVPR Best Paper, « La navigation visuelle est un domaine important de la vision par ordinateur. Cet article fait des progrès dans la navigation en langage visuel. S'appuyant sur des travaux antérieurs dans ce domaine, cet article démontre des résultats passionnants basés sur l'apprentissage de l'auto-imitation dans un cadre intermodal."

« Nous tenons à féliciter Xin Wang et William Wang pour cette reconnaissance extrêmement prestigieuse pour leur travail dans un domaine à la pointe de l'informatique, ", a déclaré Rod Alferness, doyen du Collège d'ingénierie. "Nous sommes ravis qu'ils fassent partie de la communauté UCSB."

"Je suis vraiment honoré de recevoir ce prix, " Xin Wang a dit. " Je tiens à remercier sincèrement mes conseillers William et Yuan-Fang, et les collaborateurs de MSR pour leur solide soutien et leurs précieux conseils. Quant à l'avenir, J'espère que de plus en plus de chercheurs pourront travailler sur cette direction de recherche passionnante et nécessaire, vers des robots plus pratiques et interactifs qui relient la vision et le langage pour les humains. Je vais certainement me consacrer à sa réalisation."