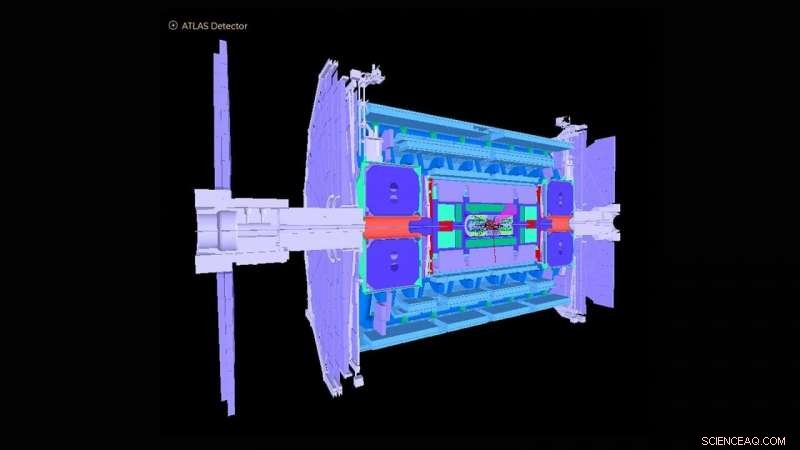

Schéma du détecteur ATLAS dans le Grand collisionneur de hadrons. Crédit :Collaboration ATLAS

Le Grand collisionneur de hadrons (LHC) près de Genève, La Suisse est devenue célèbre dans le monde en 2012 avec la détection du boson de Higgs. L'observation a marqué une confirmation cruciale du modèle standard de la physique des particules, qui organise les particules subatomiques en groupes similaires aux éléments du tableau périodique de la chimie.

Le laboratoire national d'Argonne du département américain de l'Énergie (DOE) a apporté de nombreuses contributions essentielles à la construction et à l'exploitation du détecteur expérimental ATLAS au LHC et à l'analyse des signaux enregistrés par le détecteur qui révèlent la physique sous-jacente des collisions de particules. Argonne joue désormais un rôle de premier plan dans la mise à niveau à haute luminosité du détecteur ATLAS pour des opérations dont le démarrage est prévu en 2027. À cette fin, une équipe de physiciens et de scientifiques informaticiens d'Argonne a conçu un algorithme basé sur l'apprentissage automatique qui se rapproche de la façon dont le détecteur actuel répondrait aux données considérablement accrues attendues avec la mise à niveau.

En tant que plus grande machine physique jamais construite, le LHC tire deux faisceaux de protons dans des directions opposées autour d'un anneau de 17 milles jusqu'à ce qu'ils approchent de la vitesse de la lumière, les brise ensemble et analyse les produits de collision avec des détecteurs gigantesques comme ATLAS. L'instrument ATLAS a à peu près la hauteur d'un immeuble de six étages et pèse environ 7, 000 tonnes. Aujourd'hui, le LHC continue d'étudier le boson de Higgs, ainsi que d'aborder des questions fondamentales sur comment et pourquoi la matière dans l'univers est telle qu'elle est.

"La plupart des questions de recherche à ATLAS impliquent de trouver une aiguille dans une botte de foin géante, où les scientifiques ne s'intéressent qu'à trouver un événement survenant parmi un milliard d'autres, " dit Walter Hopkins, assistant physicien dans la division Physique des Hautes Energies (HEP) d'Argonne.

Dans le cadre de la mise à niveau du LHC, les efforts progressent désormais pour multiplier par cinq la luminosité du LHC, c'est-à-dire le nombre d'interactions proton-proton par collision des deux faisceaux de protons. Cela produira environ 10 fois plus de données par an que ce qui est actuellement acquis par les expériences LHC. Dans quelle mesure les détecteurs répondent à ce taux d'événements accru doit encore être compris. Cela nécessite d'exécuter des simulations informatiques hautes performances des détecteurs pour évaluer avec précision les processus connus résultant des collisions du LHC. Ces simulations à grande échelle sont coûteuses et nécessitent une grande quantité de temps de calcul sur les supercalculateurs les meilleurs et les plus puissants du monde.

L'équipe d'Argonne a créé un algorithme d'apprentissage automatique qui sera exécuté comme simulation préliminaire avant toute simulation à grande échelle. Cet algorithme se rapproche, de manière très rapide et moins coûteuse, comment le détecteur actuel réagirait aux données considérablement accrues attendues avec la mise à niveau. Il implique la simulation des réponses du détecteur à une expérience de collision de particules et la reconstruction d'objets à partir des processus physiques. Ces objets reconstitués comprennent des jets ou sprays de particules, ainsi que des particules individuelles comme les électrons et les muons.

"La découverte d'une nouvelle physique au LHC et ailleurs exige des méthodes de plus en plus complexes pour les analyses de mégadonnées, " dit Doug Benjamin, un informaticien en HEP. "De nos jours, cela signifie généralement l'utilisation de l'apprentissage automatique et d'autres techniques d'intelligence artificielle."

Les méthodes d'analyse précédemment utilisées pour les simulations initiales n'ont pas utilisé d'algorithmes d'apprentissage automatique et prennent du temps car elles impliquent la mise à jour manuelle des paramètres expérimentaux lorsque les conditions au LHC changent. Certains peuvent également manquer des corrélations de données importantes pour un ensemble donné de variables d'entrée pour une expérience. L'algorithme développé par Argonne apprend, en temps réel pendant qu'une procédure de formation est appliquée, les différentes fonctionnalités qui doivent être introduites à travers des simulations complètes détaillées, évitant ainsi la nécessité de créer des paramètres expérimentaux à la main. La méthode peut également capturer des interdépendances complexes de variables qui n'étaient pas possibles auparavant.

"Avec notre simulation allégée, vous pouvez apprendre les bases pour un coût et un temps de calcul relativement faibles, alors vous pouvez beaucoup plus efficacement procéder à des simulations complètes à une date ultérieure, " a déclaré Hopkins. " Notre algorithme d'apprentissage automatique offre également aux utilisateurs un meilleur pouvoir de discrimination sur l'endroit où rechercher des événements nouveaux ou rares dans une expérience, " il ajouta.

L'algorithme de l'équipe pourrait s'avérer inestimable non seulement pour ATLAS, mais pour les multiples détecteurs expérimentaux du LHC, ainsi que d'autres expériences de physique des particules en cours dans le monde.

Cette étude, intitulé « Simulation automatisée de détecteurs et paramétrisation de reconstruction à l'aide de l'apprentissage automatique, " est apparu dans le Journal de l'instrumentation .