Une interface auditive cerveau-ordinateur peut dire à quel locuteur un auditeur prête attention avec une précision allant jusqu'à 80 %, en fonction du temps d'analyse. Crédit :Souto et al. ©2016 Éditions IOP

(Phys.org)—Les chercheurs travaillent sur les premières étapes d'une interface cerveau-ordinateur (BCI) qui peut dire qui vous écoutez dans une pièce pleine de bruit et d'autres personnes qui parlent. À l'avenir, la technologie pourrait être incorporée dans les aides auditives en tant que minuscules formateurs de faisceaux qui pointent dans la direction d'intérêt afin qu'ils se connectent à certaines conversations, des sons, ou des voix auxquelles un individu prête attention, tout en éliminant les bruits de fond indésirables.

Les chercheurs, Carlos da Silva Souto et coauteurs du département de physique médicale et du pôle d'excellence Hearing4all de l'Université d'Oldenburg, ont publié un article sur une preuve de concept BCI auditive dans un récent numéro de Physique biomédicale et ingénierie Express .

Jusque là, la plupart des recherches BCI se sont principalement concentrées sur les stimuli visuels, qui surpasse actuellement les systèmes utilisant des stimuli auditifs, probablement en raison de la plus grande surface corticale du système visuel par rapport au cortex auditif. Cependant, pour les personnes malvoyantes ou complètement paralysées, La BCI basée sur l'audition pourrait offrir une alternative potentielle.

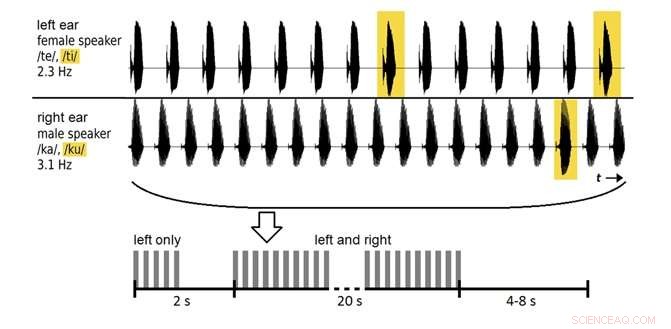

Dans la nouvelle étude, 12 volontaires ont écouté deux voix enregistrées (un homme, une femme) parlant des syllabes répétées, et on leur a demandé de prêter attention à une seule des voix. Dans les premières séances, Les données d'électroencéphalogramme (EEG) sur l'activité électrique du cerveau ont été utilisées pour former les participants. Lors des séances ultérieures, le système a été testé sur la précision avec laquelle il classait les données EEG pour déterminer à quelle voix le volontaire prêtait attention.

En premier, le système a classé les données avec une précision d'environ 60 %, au-dessus du niveau de chance, mais pas assez bon pour une utilisation pratique. En augmentant le temps d'analyse de 20 secondes à 2 minutes, les chercheurs pourraient améliorer la précision à près de 80 %. Bien que cette fenêtre d'analyse soit trop longue pour des situations réelles, et la précision peut être encore améliorée, les résultats sont parmi les premiers à montrer qu'il est possible de classer les données EEG évoquées à partir des syllabes parlées.

À l'avenir, les chercheurs prévoient d'optimiser les méthodes de classification pour améliorer encore les performances du système.

© 2017 Phys.org