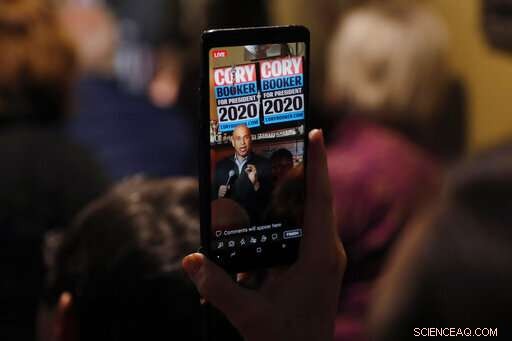

En ce 9 février 2019, fichier photo, le sénateur Cory Booker, D-N.J., est vu sur un téléphone portable alors qu'il parle lors d'une rencontre avec les résidents locaux à Marshalltown, Iowa. Le Congrès commence à montrer de l'intérêt pour ouvrir la "boîte noire" de l'intelligence artificielle des entreprises technologiques de la même manière que le gouvernement fédéral vérifie sous les capots des voitures et audite les banques. Une proposition présentée mercredi, 19 avril et co-sponsorisé par Booker, obligerait les grandes entreprises à tester la « responsabilité algorithmique » de leurs systèmes d'IA à haut risque, telles que la technologie qui détecte les visages ou prend des décisions importantes en fonction de vos données personnelles les plus sensibles. (Photo AP/Charlie Neibergall, Déposer)

Le Congrès commence à montrer de l'intérêt pour ouvrir la "boîte noire" de l'intelligence artificielle des entreprises technologiques avec une surveillance qui correspond à la façon dont le gouvernement fédéral vérifie sous les capots des voitures et audite les banques.

Une proposition présentée mercredi et coparrainée par un candidat démocrate à la présidentielle, le sénateur Cory Booker, obligerait les grandes entreprises à tester la « responsabilité algorithmique » de leurs systèmes d'IA à haut risque, telles que la technologie qui détecte les visages ou prend des décisions importantes en fonction de vos données personnelles les plus sensibles.

« Les ordinateurs sont de plus en plus impliqués dans de nombreuses décisions clés que les Américains prennent en ce qui concerne leur vie quotidienne - si quelqu'un peut acheter une maison, trouver un travail ou même aller en prison, " a déclaré le sénateur Ron Wyden dans une interview à l'Associated Press. Le démocrate de l'Oregon coparraine le projet de loi.

« Quand les entreprises se lancent vraiment dans cette question, ils vont chercher des biais dans leurs systèmes, " a déclaré Wyden. "Je pense qu'ils vont en trouver beaucoup."

La proposition des démocrates est la première du genre, et pourrait faire face à une bataille difficile au Sénat dirigé par les républicains. Mais cela reflète l'examen croissant et bipartite de l'économie des données en grande partie non réglementée, tout ce qui provient des flux de médias sociaux, courtage de données en ligne, algorithmes financiers et logiciels d'auto-conduite qui impactent de plus en plus la vie quotidienne. Un projet de loi bipartite du Sénat présenté le mois dernier obligerait les entreprises à avertir les personnes avant d'utiliser un logiciel de reconnaissance faciale sur elles, tout en exigeant également des tests tiers pour vérifier les problèmes de biais.

Des études universitaires et des exemples concrets ont mis au jour des systèmes de reconnaissance faciale qui identifient mal les femmes à la peau plus foncée, des outils de prêt informatisés qui facturent des taux d'intérêt plus élevés aux emprunteurs latinos et noirs, et des outils de recrutement qui favorisent les hommes dans les secteurs où ils dominent déjà.

En ce 20 mars, 2019, les photographes prennent des photos avec leur téléphone pendant que le président Donald Trump s'exprime au Joint Systems Manufacturing Center à Lima, Ohio. Le Congrès commence à montrer de l'intérêt pour ouvrir la "boîte noire" de l'intelligence artificielle des entreprises technologiques de la même manière que le gouvernement fédéral vérifie sous les capots des voitures et audite les banques. L'administration du président Donald Trump en prend également note et a intégré le développement d'algorithmes « dignes de confiance » à la nouvelle initiative d'IA de la Maison Blanche. (AP Photo/Michael Conroy, Déposer)

"Il y a ce mythe que les algorithmes sont ces neutres, choses objectives, " a déclaré Aaron Rieke, directeur général du groupe de plaidoyer Upturn. "L'apprentissage automatique reprend des modèles dans la société :qui fait quoi, qui achète quoi, ou qui a quel travail. Ce sont des modèles façonnés par des problèmes avec lesquels nous nous débattons depuis des décennies. »

L'administration du président Donald Trump en prend également note et a fait du développement d'algorithmes "sûrs et dignes de confiance" un objectif majeur de la nouvelle initiative d'IA de la Maison Blanche. Mais il le ferait principalement en renforçant un processus existant axé sur l'industrie de création de normes technologiques.

« Il faut une plus grande transparence et une plus grande comparabilité des données, " et pour détecter et réduire les biais dans ces systèmes, a déclaré le sous-secrétaire au Commerce Walter Copan, qui dirige l'Institut national des normes et de la technologie. "Les consommateurs volent essentiellement à l'aveugle."

Des dizaines de développeurs de reconnaissance faciale, y compris des entreprises de marque comme Microsoft, l'année dernière, ils ont soumis leurs algorithmes propriétaires à l'agence de Copan afin qu'ils puissent être évalués et comparés les uns aux autres. Les résultats ont montré des gains de précision significatifs par rapport aux années précédentes.

Mais Wyden a déclaré que les normes volontaires ne suffisaient pas.

"L'autorégulation a clairement échoué ici, " il a dit.

En ce 28 juin, 2018, photo d'archives, le sénateur Ron Wyden, D-Ore., membre de premier rang de la commission des finances du Sénat, prend la parole lors d'une audition à Capitol Hill à Washington. Le Congrès commence à montrer de l'intérêt pour ouvrir la "boîte noire" de l'intelligence artificielle des entreprises technologiques avec une surveillance parallèle à la façon dont le gouvernement fédéral vérifie sous les capots des voitures et audite les banques. Une proposition présentée mercredi, 10 avril, 2018 et coparrainé par Wyden exigerait des grandes entreprises qu'elles testent la « responsabilité algorithmique » de leurs systèmes d'IA qui aident à prendre d'importantes décisions en matière de justice pénale et affectent l'accès des personnes au logement, crédit et emplois. (AP Photo/Jacquelyn Martin, Déposer)

Dans un geste plus audacieux de l'administration Trump, le ministère fédéral du Logement et du Développement urbain a accusé Facebook de permettre aux propriétaires et aux courtiers immobiliers d'exclure systématiquement des groupes tels que les non-chrétiens, les immigrés et les minorités de voir des annonces de maisons et d'appartements.

Booker, dans une déclaration au sujet de son projet de loi, a déclaré que même si l'action Facebook de HUD est une étape importante, il est nécessaire de creuser plus profondément pour lutter contre les « moyens pernicieux » de la discrimination sur les plateformes technologiques, parfois involontairement.

Booker a déclaré que les algorithmes biaisés provoquaient le même type de pratiques immobilières discriminatoires qui cherchaient à éloigner ses parents du New Jersey et d'autres couples noirs de certains quartiers américains à la fin des années 1960. Cette fois, il a dit, il est plus difficile à détecter et à combattre.

Le projet de loi que lui et Wyden ont présenté permettrait à la Federal Trade Commission d'établir et d'appliquer de nouvelles règles permettant aux entreprises de vérifier l'exactitude, biais et problèmes potentiels de confidentialité ou de sécurité dans leurs systèmes automatisés, et corrigez-les si des problèmes sont détectés. Il exonère les petites entreprises qui gagnent moins de 50 millions de dollars par an, à moins qu'il ne s'agisse de courtiers en données disposant d'informations sur au moins 1 million de consommateurs.

Yvette Clarke, représentante démocrate de New York, qui présente un projet de loi connexe à la Chambre, dit que le but est de résoudre les problèmes, pas seulement pour les évaluer. Elle a déclaré qu'il était logique de donner à la FTC le pouvoir de surveiller régulièrement les performances de ces systèmes, car elle "a le doigt sur le pouls de ce qui arrive aux consommateurs".

© 2019 La Presse Associée. Tous les droits sont réservés.