Crédit :Université de technologie du Queensland

Les chercheurs de QUT ont développé une nouvelle façon pour les robots de voir le monde d'un point de vue plus humain, qui a le potentiel d'améliorer la façon dont la technologie, tels que les voitures sans conducteur et les robots industriels et mobiles, fonctionne et interagit avec les gens.

Dans ce qui est considéré comme une première mondiale, doctorat étudiant Sourav Garg, Le Dr Niko Suenderhauf et le professeur Michael Milford de la Faculté des sciences et d'ingénierie de QUT et du Centre australien de vision robotique, ont utilisé la sémantique visuelle pour permettre une reconnaissance de lieux haute performance à partir de points de vue opposés.

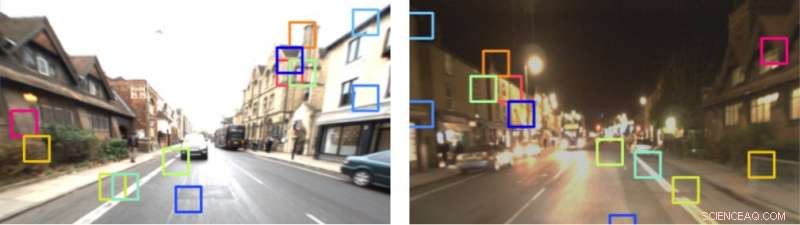

M. Garg a dit, alors que les humains avaient une capacité remarquable à reconnaître un endroit lorsqu'ils y rentraient dans la direction opposée, y compris dans des circonstances où il existe des variations extrêmes dans son apparence, la tâche avait présenté des défis pour les robots et les véhicules autonomes.

"Par exemple, si une personne conduit sur une route et qu'elle fait demi-tour et redescend sur la même route, dans la direction opposée, ils ont la capacité de savoir où ils sont, sur la base de cette expérience antérieure, parce qu'ils reconnaissent les aspects clés de l'environnement. Les gens peuvent aussi le faire s'ils empruntent la même route la nuit, et puis de nouveau pendant la journée, ou à différentes saisons, " a déclaré M. Garg.

"Malheureusement, ce n'est pas si simple pour les robots. Solutions techniques actuelles, tels que ceux utilisés par les voitures sans conducteur, reposent en grande partie sur des caméras panoramiques ou sur la détection de détection de lumière et de télémétrie à 360 degrés (LIDAR). Bien que cela soit efficace, c'est très différent de la façon dont les humains naviguent naturellement.

Crédit :neyro2008 / Alexander Zelnitskiy / 123rf.com / auteurs

Le professeur Michael Milford a déclaré que le système proposé par l'équipe de chercheurs de QUT utilisait un réseau de segmentation sémantique de pointe, appelé RefineNet, formé sur le jeu de données Cityscapes, pour former un descripteur de tenseur sémantique local (LoST) d'images. Cela a ensuite été utilisé pour effectuer une reconnaissance de lieu ainsi que des techniques de vision robotique supplémentaires basées sur des contrôles de vérification de la disposition spatiale et une correspondance des points clés pondérés.

« Nous voulions reproduire le processus utilisé par les humains. La sémantique visuelle fonctionne non seulement en détectant, mais comprendre où se trouvent les objets clés dans l'environnement, et cela permet une plus grande prévisibilité dans les actions qui suivent, " dit le professeur Milford.

"Notre approche nous permet de faire correspondre des lieux à partir de points de vue opposés avec peu de chevauchement visuel commun et à travers les cycles jour-nuit. Nous étendons maintenant ce travail pour gérer à la fois les points de vue opposés et le changement de point de vue latéral, qui se produit, par exemple, lorsqu'un véhicule change de voie. Cela ajoute un degré de difficulté supplémentaire."

Crédit : 1 an, 1000 km :le jeu de données Oxford RobotCar

L'article de l'équipe de recherche a été accepté pour publication dans Robotique :science et systèmes , la conférence internationale de robotique la plus sélective, qui se tient à l'Université Carnegie Mellon de Pittsburgh ce mois-ci.