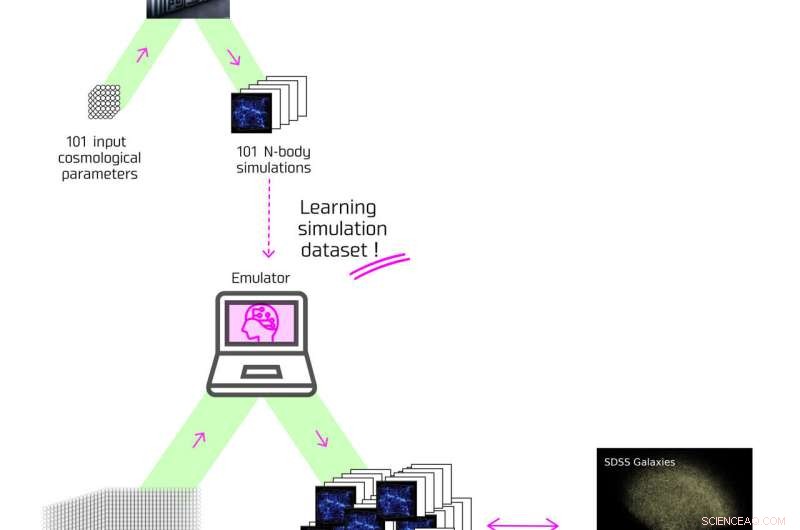

Organigramme du fonctionnement de l'émulateur développé par l'équipe de recherche. Crédit :Kavli IPMU, NAOJ

En appliquant une technique d'apprentissage automatique, une méthode de réseau neuronal, à des quantités gigantesques de données de simulation sur la formation de structures cosmiques dans l'univers, une équipe de chercheurs a développé un logiciel très rapide et très efficace qui peut faire des prédictions théoriques sur la structure formation. En comparant les prédictions du modèle aux ensembles de données d'observation réels, l'équipe a réussi à mesurer avec précision les paramètres cosmologiques, rapporte une étude dans Physical Review D .

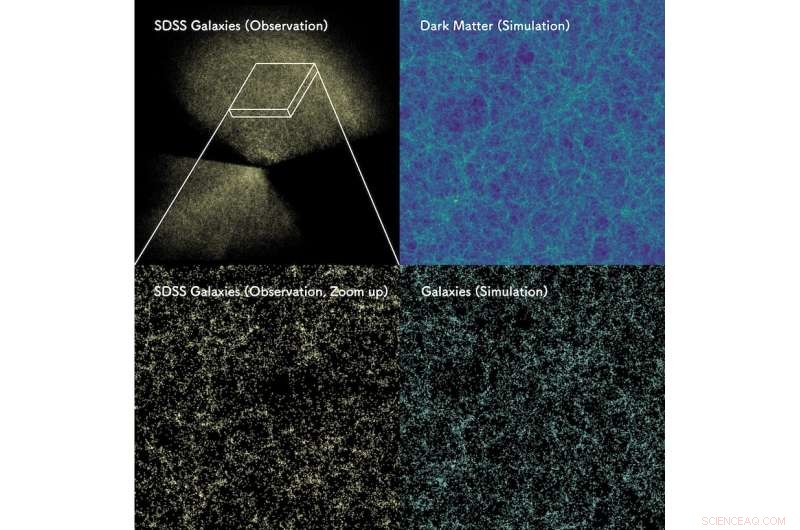

Lorsque la plus grande enquête sur les galaxies à ce jour au monde, le Sloan Digital Sky Survey (SDSS), a créé une carte tridimensionnelle de l'univers via la distribution observée des galaxies, il est devenu clair que les galaxies avaient certaines caractéristiques. Certaines s'agglutinaient ou s'étalaient en filaments, et à certains endroits, il y avait des vides là où aucune galaxie n'existait. Toutes ces galaxies montrent n'ont pas évolué de manière uniforme, elles se sont formées en raison de leur environnement local. En général, les chercheurs s'accordent à dire que cette répartition non uniforme des galaxies est due aux effets de la gravité causés par la répartition de la matière noire "invisible", la matière mystérieuse que personne n'a encore directement observée.

En étudiant en détail les données de la carte tridimensionnelle des galaxies, les chercheurs ont pu découvrir les quantités fondamentales telles que la quantité de matière noire dans l'univers. Ces dernières années, les simulations à N corps ont été largement utilisées dans des études recréant la formation de structures cosmiques dans l'univers. Ces simulations imitent les inhomogénéités initiales à des décalages vers le rouge élevés par un grand nombre de particules à N corps qui représentent efficacement les particules de matière noire, puis simulent l'évolution de la distribution de la matière noire dans le temps, en calculant les forces d'attraction gravitationnelles entre les particules dans un univers en expansion. Cependant, les simulations sont généralement coûteuses, prenant des dizaines d'heures sur un supercalculateur, même pour un modèle cosmologique.

Répartition d'environ 1 million de galaxies observées par Sloan Digital Sky Survey (en haut à gauche) et une image agrandie de la mince région rectangulaire (en bas à gauche). Cela peut être comparé à la distribution de matière noire invisible prédite par la simulation de superordinateur en supposant le modèle cosmologique que notre IA dérive (en haut à droite). Le coin inférieur droit montre la distribution des fausses galaxies qui se forment dans des régions à forte densité de matière noire. La distribution prédite des galaxies partage les modèles caractéristiques tels que les amas de galaxies, les filaments et les vides observés dans les données SDSS réelles. Crédit :Takahiro Nishimichi

Une équipe de chercheurs, dirigée par l'ancien chercheur du projet Kavli Institute for the Physics and Mathematics of the Universe (Kavli IPMU) Yosuke Kobayashi (actuellement associé de recherche postdoctoral à l'Université de l'Arizona), et comprenant le professeur Kavli IPMU Masahiro Takada et Kavli IPMU Visiting Scientists Takahiro Nishimichi et Hironao Miyatake, ont combiné l'apprentissage automatique avec des données de simulation numérique par le supercalculateur "ATERUI II" à l'Observatoire astronomique national du Japon (NAOJ) pour générer des calculs théoriques du spectre de puissance, la quantité la plus fondamentale mesurée à partir d'enquêtes sur les galaxies qui indique aux chercheurs statistiquement comment les galaxies sont distribuées dans l'univers.

Habituellement, plusieurs millions de simulations à N corps devraient être exécutées, mais l'équipe de Kobayashi a pu utiliser l'apprentissage automatique pour apprendre à son programme à calculer le spectre de puissance au même niveau de précision qu'une simulation, même pour un modèle cosmologique pour lequel la simulation n'avait pas encore été lancée. Cette technologie s'appelle un émulateur et est déjà utilisée dans les domaines de l'informatique en dehors de l'astronomie.

"En combinant l'apprentissage automatique avec des simulations numériques, qui coûtent cher, nous avons pu analyser les données d'observations astronomiques avec une grande précision. Ces émulateurs ont déjà été utilisés dans des études de cosmologie, mais presque personne n'a pu prendre en compte les nombreuses d'autres effets, ce qui compromettrait les résultats des paramètres cosmologiques en utilisant de vraies données d'enquête sur les galaxies. Notre émulateur analyse et a pu analyser des données d'observation réelles. Cette étude a ouvert une nouvelle frontière à l'analyse de données structurelles à grande échelle », a déclaré l'auteur principal Kobayashi .

Cependant, pour appliquer l'émulateur aux données réelles d'enquête sur les galaxies, l'équipe a dû prendre en compte l'incertitude du "biais de galaxie", une incertitude tenant compte du fait que les chercheurs ne peuvent pas prédire avec précision où les galaxies se forment dans l'univers en raison de leur physique compliquée inhérente à la formation des galaxies. .

Pour surmonter cette difficulté, l'équipe s'est concentrée sur la simulation de la distribution des "halos" de matière noire, où il y a une forte densité de matière noire et une forte probabilité de formation de galaxies. L'équipe a réussi à faire une prédiction de modèle flexible pour un modèle cosmologique donné, en introduisant un nombre suffisant de paramètres de "nuisance" pour prendre en compte l'incertitude du biais de la galaxie.

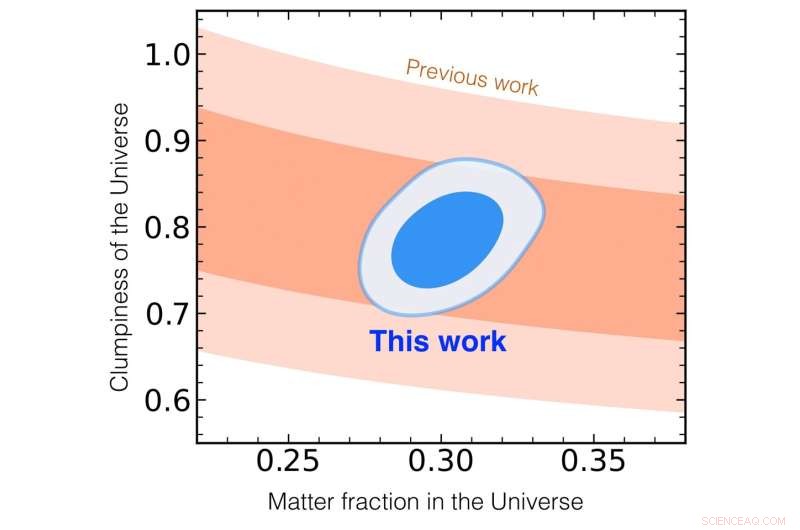

Une comparaison de la carte tridimensionnelle des galaxies du Sloan Digital Sky Survey et des résultats générés par l'émulateur développé par Kobayashi et al. L'axe des x montre la fraction de matière dans l'univers actuel, l'axe des y montre les paramètres physiques correspondant à l'agrégation de l'univers actuel (plus le nombre est grand, plus il y a de galaxies dans cet univers). Les bandes bleu clair et bleu foncé correspondent à 68% et 95% de confiance, et à l'intérieur de cette zone montre la probabilité qu'il y ait une valeur réelle de l'univers ici. La bande orange correspond aux résultats de la SSDS. Crédit :Yosuke Kobayashi

Ensuite, l'équipe a comparé la prédiction du modèle à un ensemble de données SDSS réel et a mesuré avec succès les paramètres cosmologiques avec une grande précision. Il confirme en tant qu'analyse indépendante que seulement 30% environ de toute l'énergie provient de la matière (principalement de la matière noire) et que les 70% restants sont le résultat de l'énergie noire provoquant l'expansion accélérée de l'univers. Ils ont également réussi à mesurer l'agglutination de la matière dans notre univers, alors que la méthode classique utilisée pour analyser les cartes 3D des galaxies n'était pas en mesure de déterminer ces deux paramètres simultanément.

La précision de la mesure de leurs paramètres dépasse celle obtenue par les analyses précédentes des relevés de galaxies. Ces résultats démontrent l'efficacité de l'émulateur développé dans cette étude. La prochaine étape pour l'équipe de recherche sera de continuer à étudier la masse de matière noire et la nature de l'énergie noire en appliquant leur émulateur aux cartes de galaxies qui seront capturées par le Prime Focus Spectrograph, en cours de développement, dirigé par le Kavli IPMU, pour être monté sur le télescope Subaru de NAOJ. Outil d'intelligence artificielle développé pour prédire la structure de l'univers