Un détecteur de muons en forme de roue fait partie d'une mise à niveau du détecteur de particules ATLAS au CERN. Une nouvelle étude s'applique au "déroulement, " ou des techniques de correction d'erreurs utilisées pour les détecteurs de particules, aux problèmes de bruit en informatique quantique. Crédit :Julien Marius Ordan/CERN

Empruntant une page de manuels de physique des hautes énergies et d'astronomie, une équipe de physiciens et d'informaticiens du laboratoire national Lawrence Berkeley du département de l'Énergie des États-Unis (Berkeley Lab) a adapté et appliqué avec succès une technique commune de réduction des erreurs dans le domaine de l'informatique quantique.

Dans le monde des particules subatomiques et des détecteurs de particules géantes, et les galaxies lointaines et les télescopes géants, les scientifiques ont appris à vivre, et travailler, avec incertitude. Ils essaient souvent de démêler les interactions de particules ultra-rares à partir d'un enchevêtrement massif d'autres interactions de particules et de "bruits" de fond qui peuvent compliquer leur chasse, ou essayer de filtrer les effets des distorsions atmosphériques et de la poussière interstellaire pour améliorer la résolution de l'imagerie astronomique.

Aussi, problèmes inhérents aux détecteurs, comme avec leur capacité à enregistrer toutes les interactions de particules ou à mesurer exactement les énergies des particules, peut entraîner une mauvaise lecture des données par l'électronique à laquelle elles sont connectées, les scientifiques doivent donc concevoir des filtres complexes, sous forme d'algorithmes informatiques, pour réduire la marge d'erreur et renvoyer les résultats les plus précis.

Les problèmes de bruit et de défauts physiques, et le besoin d'algorithmes de correction et d'atténuation des erreurs, qui réduisent la fréquence et la gravité des erreurs, sont également courants dans le domaine naissant de l'informatique quantique, et une étude publiée dans la revue Informations quantiques npj constaté qu'il semble y avoir des solutions communes, trop.

Ben Nachman, un physicien du Berkeley Lab qui participe aux expériences de physique des particules au CERN en tant que membre du groupe ATLAS du Berkeley Lab, vu la connexion de l'informatique quantique en travaillant sur un calcul de physique des particules avec Christian Bauer, un physicien théoricien de Berkeley Lab qui est co-auteur de l'étude. ATLAS est l'un des quatre détecteurs de particules géants du Grand collisionneur de hadrons du CERN, le plus grand et le plus puissant collisionneur de particules au monde.

« Chez ATLAS, nous devons souvent « déployer, ' ou corriger les effets du détecteur, " dit Nachman, l'auteur principal de l'étude. « Les gens développent cette technique depuis des années.

Dans des expériences au LHC, des particules appelées protons entrent en collision à une vitesse d'environ 1 milliard de fois par seconde. Pour faire face à cette incroyablement chargée, environnement "bruyant" et problèmes intrinsèques liés à la résolution énergétique et autres facteurs associés aux détecteurs, les physiciens utilisent des techniques de "dépliage" de correction d'erreurs et d'autres filtres pour trier ce fouillis de particules au plus utile, données précises.

"Nous avons réalisé que les ordinateurs quantiques actuels sont très bruyants, trop, " Nachman a dit, Par conséquent, trouver un moyen de réduire ce bruit et de minimiser les erreurs (l'atténuation des erreurs) est essentiel pour faire progresser l'informatique quantique. "Un type d'erreur est lié aux opérations réelles que vous effectuez, et l'un concerne la lecture de l'état de l'ordinateur quantique, " il a noté - ce premier type est connu comme une erreur de porte, et ce dernier est appelé erreur de lecture.

La dernière étude se concentre sur une technique pour réduire les erreurs de lecture, appelé "déploiement bayésien itératif" (IBU), qui est familier à la communauté de la physique des hautes énergies. L'étude compare l'efficacité de cette approche à d'autres techniques de correction et d'atténuation des erreurs. La méthode IBU est basée sur le théorème de Bayes, qui fournit un moyen mathématique de trouver la probabilité qu'un événement se produise lorsqu'il existe d'autres conditions liées à cet événement qui sont déjà connues.

Nachman a noté que cette technique peut être appliquée à l'analogique quantique des ordinateurs classiques, connus sous le nom d'ordinateurs quantiques universels basés sur des portes.

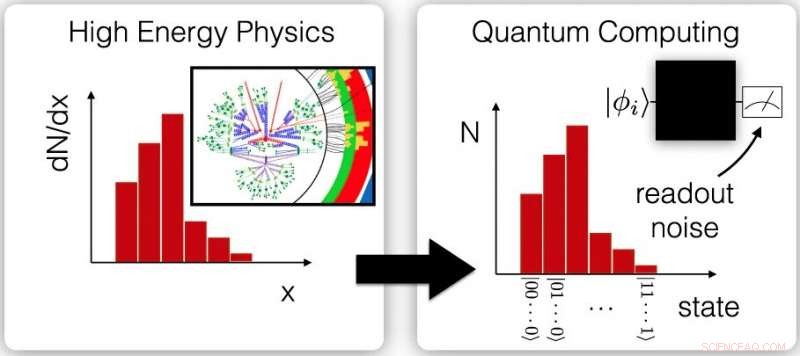

Ces graphiques montrent le lien entre les mesures triées de physique des hautes énergies liées à la diffusion des particules - appelées mesures de section efficace différentielle (à gauche) - et les mesures répétées des sorties d'ordinateurs quantiques (à droite). Ces similitudes offrent la possibilité d'appliquer des techniques similaires d'atténuation des erreurs aux données des deux domaines. Crédit :Laboratoire de Berkeley ; Inf quantique npj 6, 84 (2020), DOE :10.1038/s41534-020-00309-7

En informatique quantique, qui repose sur des bits quantiques, ou qubits, porter des informations, l'état fragile connu sous le nom de superposition quantique est difficile à maintenir et peut se dégrader avec le temps, faire en sorte qu'un qubit affiche un zéro au lieu d'un - c'est un exemple courant d'erreur de lecture.

La superposition prévoit qu'un bit quantique peut représenter un zéro, un, ou les deux quantités à la fois. Cela permet des capacités de calcul uniques impossibles dans l'informatique conventionnelle, qui reposent sur des bits représentant soit un un soit un zéro, mais pas les deux à la fois. Une autre source d'erreur de lecture dans les ordinateurs quantiques est simplement une mesure erronée de l'état d'un qubit en raison de l'architecture de l'ordinateur.

Dans l'étude, les chercheurs ont simulé un ordinateur quantique pour comparer les performances de trois techniques différentes de correction d'erreurs (ou d'atténuation d'erreurs ou de déploiement). Ils ont constaté que la méthode IBU est plus robuste dans un environnement très bruyant, environnement sujet aux erreurs, et a légèrement surpassé les deux autres en présence de modèles de bruit plus courants. Ses performances ont été comparées à une méthode de correction d'erreurs appelée Ignis qui fait partie d'une collection d'outils de développement de logiciels d'informatique quantique open source développés pour les ordinateurs quantiques d'IBM, et une forme très basique de dépliage connue sous le nom de méthode d'inversion de matrice.

Les chercheurs ont utilisé l'environnement informatique quantique simulé pour produire plus de 1, 000 pseudo-expériences, et ils ont constaté que les résultats de la méthode IBU étaient les plus proches des prédictions. Les modèles de bruit utilisés pour cette analyse ont été mesurés sur un ordinateur quantique de 20 qubits appelé IBM Q Johannesburg.

"Nous avons pris une technique très courante de la physique des hautes énergies, et l'a appliqué à l'informatique quantique, et cela a très bien fonctionné, comme il se doit, " a déclaré Nachman. Il y avait une courbe d'apprentissage abrupte. " J'ai dû apprendre toutes sortes de choses sur l'informatique quantique pour être sûr de savoir comment traduire cela et l'implémenter sur un ordinateur quantique. "

Il a dit qu'il était également très chanceux de trouver des collaborateurs pour l'étude avec une expertise en informatique quantique au Berkeley Lab, dont Bert de Jong, qui dirige une équipe DOE Office of Advanced Scientific Computing Research Quantum Algorithms et un projet de recherche accélérée pour l'informatique quantique dans la division de recherche informatique du Berkeley Lab.

"C'est passionnant de voir comment la pléthore de connaissances développées par la communauté de la physique des hautes énergies pour tirer le meilleur parti des expériences bruyantes peut être utilisée pour tirer le meilleur parti des ordinateurs quantiques bruyants, " a déclaré de Jong.

Les ordinateurs quantiques simulés et réels utilisés dans l'étude variaient de cinq qubits à 20 qubits, et la technique doit être évolutive à des systèmes plus importants, dit Nachman. Mais les techniques de correction et d'atténuation des erreurs que les chercheurs ont testées nécessiteront plus de ressources informatiques à mesure que la taille des ordinateurs quantiques augmente, Nachman a donc déclaré que l'équipe se concentre sur la façon de rendre les méthodes plus gérables pour les ordinateurs quantiques avec des matrices de qubits plus grandes.

Nachman, Bauer, et de Jong a également participé à une étude antérieure qui propose un moyen de réduire les erreurs de porte, qui est l'autre source majeure d'erreurs en calcul quantique. Ils pensent que la correction et l'atténuation des erreurs dans l'informatique quantique peuvent finalement nécessiter une approche mixte, utilisant une combinaison de plusieurs techniques.

"C'est une période passionnante, " Nachman a dit, car le domaine de l'informatique quantique est encore jeune et il y a beaucoup de place pour l'innovation. "Les gens ont au moins compris le message sur ces types d'approches, et il y a encore de la place pour le progrès." Il a noté que l'informatique quantique a fourni " ajouter, "Cela a ouvert un nouveau potentiel scientifique."