Crédit:lightcommands.com

Des lasers brillants sur des assistants vocaux comme Alexa et Siri, des chercheurs du Michigan et du Japon ont réalisé un hack où les lasers avaient le pouvoir de commandes de la voix humaine.

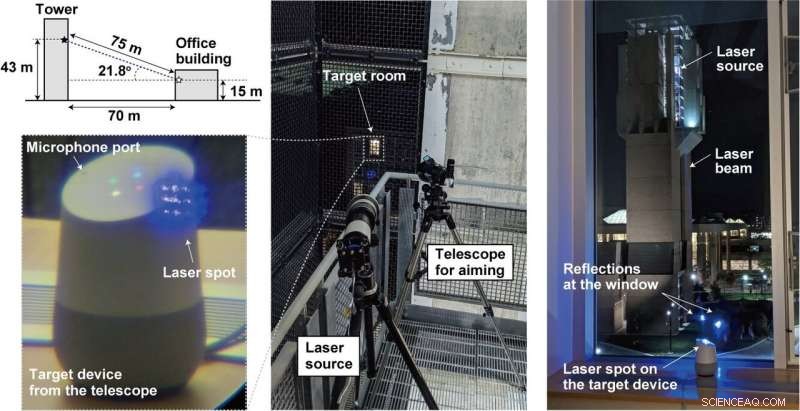

En braquant le laser à travers la fenêtre sur des microphones à l'intérieur d'appareils tels que des tablettes, ou téléphones, un attaquant éloigné peut envoyer à distance des commandes inaudibles et potentiellement invisibles sur lesquelles Alexa agit, Portail, Assistant Google ou Siri.

Tout simplement, un attaquant peut détourner l'assistant vocal et envoyer des commandes.

Comment l'équipe a-t-elle transformé la lumière en son ? Une vulnérabilité dans les microphones utilisant des systèmes micro-électro-mécaniques (MEMS) est exploitée. Les composants MEMS réagissent involontairement à la lumière comme s'il s'agissait d'un son, mentionné Ars Technica .

Quel est le pire qui puisse arriver ? Beaucoup. Ars Technica décrit les lasers injectant des commandes inaudibles dans les appareils et les faisant subrepticement "déverrouiller les portes, visiter des sites Web, et localiser, ouvrir, et démarrer les véhicules."

Les chercheurs ont discuté de leurs travaux dans leur article publié lundi. "Light Commands:Laser-Based Audio Injection Attacks on Voice-Controllable Systems" est rédigé par cinq auteurs affiliés à l'Université du Michigan (quatre) et à l'Université d'Electro-Communications, Japon (un).

« Dans notre journal, " ils ont dit, "nous démontrons cet effet, utiliser avec succès la lumière pour injecter des commandes malveillantes dans plusieurs appareils à commande vocale tels que des haut-parleurs intelligents, comprimés, et des téléphones sur de grandes distances et à travers des vitres."

A-t-il été facile à réaliser ?

Pour contrecarrer l'authentification, assez facile.

"Les systèmes à commande vocale n'exigent souvent pas que les utilisateurs s'authentifient, " a écrit Ars Technica c'est Dan Goodin. L'attaque dans ces cas pourrait être fréquemment effectuée sans avoir besoin de mots de passe ou de codes PIN. Souvent. "Même lorsque les systèmes nécessitent une authentification pour certaines actions, " il ajouta, "il peut être possible de forcer brutalement le code PIN, car de nombreux appareils ne limitent pas le nombre de suppositions qu'un utilisateur peut faire."

Aussi, l'attaque n'était pas chère à mener. Les commandes lumineuses peuvent être montées à moindre coût, a déclaré un présentateur vidéo, en utilisant des pointeurs laser ordinaires. Cela pourrait même être fait entre deux bâtiments.

L'équipe a déclaré avoir tenté son attaque contre les systèmes de reconnaissance vocale populaires, à savoir Amazon Alexa, Pomme Siri, Portail Facebook, et l'Assistant Google. Réellement, bien que, "tout système qui utilise des microphones MEMS et agit sur ces données sans confirmation supplémentaire de l'utilisateur peut être vulnérable, " selon leur propre site de commandes lumineuses.

Quel est le danger avec les commandes de lumière ?

Alexa, quel temps fait-il ? C'est inoffensif. L'attaquant peut contrôler les commutateurs de la maison intelligente. Ouvrez les portes de garage intelligentes. Démarrez les véhicules à distance. En réalité, vous pouvez regarder une vidéo en injectant "OK Google, ouvrez la porte du garage" à un Google Home simplement en faisant briller un pointeur laser bon marché.

Que peut-on faire pour se protéger contre la vulnérabilité ? Le présentateur vidéo a déclaré que la vulnérabilité de base ne peut pas être résolue sans une refonte coûteuse du microphone.

"Nous collaborons avec Amazon, Google, Pomme, ainsi que d'autres fournisseurs sur les mesures défensives. » Ils ont plus d'informations et de démonstrations sur lightcommands.com.

"Une couche d'authentification supplémentaire peut être efficace pour atténuer quelque peu l'attaque. Alternativement, dans le cas où l'attaquant ne peut pas espionner la réponse de l'appareil, demander à l'appareil de poser à l'utilisateur une simple question aléatoire avant l'exécution de la commande peut être un moyen efficace d'empêcher l'attaquant d'obtenir l'exécution de la commande avec succès.

« Les fabricants peuvent également tenter d'utiliser des techniques de fusion de capteurs, comme acquérir l'audio de plusieurs microphones. Lorsque l'attaquant utilise un seul laser, un seul microphone reçoit un signal tandis que les autres ne reçoivent rien...

Une autre approche consiste à réduire la quantité de lumière atteignant le diaphragme du microphone en utilisant une barrière qui bloque physiquement les faisceaux lumineux rectilignes pour éliminer la ligne de mire vers le diaphragme, ou mettre en place un couvercle non transparent au-dessus du trou du microphone pour atténuer la quantité de lumière frappant le microphone. Cependant, on constate que de telles barrières physiques ne sont efficaces que jusqu'à un certain point, comme un attaquant peut toujours augmenter la puissance laser pour tenter de compenser l'atténuation induite par la couverture ou pour brûler à travers les barrières, créant un nouveau chemin lumineux."

Ce qui précède est apparu sur leur site de commandes légères, tandis que le document a également discuté des approches et des limites d'atténuation.

Pendant ce temps, Mariella Lune dans Engagé a rappelé à ses lecteurs que ce ne serait pas la première fois que des chercheurs découvriraient des vulnérabilités dans les assistants numériques. « Des chercheurs de l'université chinoise du Zheijiang ont découvert que Siri, Alexa et d'autres assistants vocaux peuvent être manipulés avec des commandes envoyées en fréquences ultrasonores."

© 2019 Réseau Science X